En kognitiv forskare tror att den ledande metod för lärande kan förbättras genom idéer som vaskats fram från att studera barn.

Precis som alla stolta fadern, Gary Marcus är bara alltför glada att tala om de senaste resultaten av hans två-åriga son. Mer ovanligt, han anser att det sätt som hans barn lär sig och skäl som kan inneha nyckeln till att göra maskiner mycket mer intelligent.

Sitter i styrelserummet på en livlig Manhattan start inkubator, Marcus, en 45-årig professor i psykologi vid New York University och grundare av ett nytt företag som heter Geometriska Intelligens, beskriver ett exempel på hans pojke uppfinningsrikedom. Från baksätet i bilen, hans son hade sett en skylt som visar antalet 11, och eftersom han visste att andra tvåsiffriga tal hade namn som “thirty-three” och “sjuttio”, frågade han sin far om numret på skylten var “onety och en.”

“Han hade slutsatsen att det finns en regel om hur du placerar dina nummer tillsammans”, förklarar Marcus med ett leende. “Nu, han hade overgeneralized det, och han gjorde ett misstag, men det var en mycket sofistikerad misstag.”

Marcus har en mycket annorlunda perspektiv från många av datavetare och matematiker nu i spetsen av artificiell intelligens. Han har tillbringat årtionden studerat hur det mänskliga sinnet fungerar och hur barn lär sig nya färdigheter såsom språk och musikalitet. Detta har lett honom att tro att om forskarna vill skapa verkligt avancerad artificiell intelligens—något som lätt lär sig om världen—de måste ta inspiration från vägen småbarn plocka upp nya begrepp och generalisera. Och det är en av de stora inspirationskällor för hans nya företag, som han kör även på ett års ledighet från NYU. Med sin radikala syn på lärande, Geometriska Intelligence syftar till att skapa algoritmer för användning i en AI som kan lära sig nya och bättre sätt.

Är djupt lärande som bygger på en modell som är för enkelt? Marcus tycker datavetare saknas en enorm möjlighet, genom att ignorera många nyanser av det mänskliga sinnet.

Numera nästan alla andra som försöker kommersialisera AI, från Google Baidu, fokuserar på algoritmer som ungefär modell för hur nervceller och synapser i hjärnan förändras när de utsätts för ny information och nya erfarenheter. Denna strategi, som kallas djup lärande, har producerat några fantastiska resultat under de senaste åren, framför allt eftersom mer data och mer kraftfull hårdvara har gjort det underliggande beräkningar för att växa i omfattning. Djup-inlärning har matchat—eller rentav överskridit—den mänskliga noggrannhet i att känna igen ansikten på bilder eller identifiera orden i ljud-inspelningar. Google, Facebook och andra stora företag som tillämpar metoden att bara om någon uppgift där det är användbart för att upptäcka ett mönster i stora mängder data, såsom att förfina sökresultat eller undervisning i hur datorer att föra en konversation (se “Undervisning Maskiner för att Förstå Oss”).

Men är djupt lärande som bygger på en modell av en hjärna som är för enkel? Geometriska Intelligens—ja, Marcus och för sig, satsar på att datorn forskare saknas en enorm möjlighet, genom att ignorera många nyanser i hur det mänskliga sinnet fungerar. I sitt skrivande, offentliga framträdanden, och kommentarer till pressen, Marcus kan vara en hård kritiker av den entusiasm för djupt lärande. Men trots hans ibland slipande strategi, han ger en värdefull counterperspective. Bland annat påpekar han att dessa system behöver matas många tusentals exempel för att lära sig något. Forskare som försöker utveckla maskiner som klarar av att samtala naturligt med människor gör det genom att ge sina system otaliga avskrifter av tidigare konversationer. Detta kan mycket väl producera något kan enkel konversation, men den kognitiva vetenskapen tyder på att det är inte hur det mänskliga sinnet förvärvar språk.

I motsats, en två-årig förmåga att lära sig genom att överföra och generalisera—om än ofullständigt—är långt mer sofistikerade. Klart hjärnan är kapabel till mer än att bara känna igen mönster i stora mängder data: den har ett sätt att skaffa sig djupare abstraktioner från relativt lite data. Ge maskiner även en grundläggande förmåga att lära sig sådana abstraktioner snabbt skulle vara ett viktigt framsteg. En självgående bil kanske inte behöver resa miljontals km för att lära sig att hantera nya villkor väg. Eller en robot som kunde identifiera och hämta en flaska piller det har visat sig att bara en eller två gånger. Med andra ord, dessa maskiner skulle tänka och agera lite mer det sätt vi gör.

Med lite ovårdade hår och ett par dagars stubb, Marcus verkar väl anpassade till sin nya roll som entreprenör. I hans företags utrymme, en handfull av programmerare arbeta bort på dyra datorer som kör kraftfulla grafik-processorer. Vid ett tillfälle, när Marcus vill att illustrera en punkt om hur hjärnan fungerar, han böjer sig för vad han tycker är en whiteboard markör. Det visar sig vara en missriktad pil från en Nerf pistol.

Marcus pratar snabbt när du blivit upphetsad, och han har en snabb humor och en busig flin. Han vägrar att förklara exakt vilka produkter och applikationer för hans företag att arbeta på, av rädsla för att ett stort företag som Google kan få en fördel genom att lära sig den viktiga insikter bakom det. Men han säger att det har utvecklat algoritmer som kan lära sig från relativt små mängder data och kan även dra slutsatser och generalisera, i ett grovt sätt, från den information de är trötta. Marcus säger att hans lag har testat dessa algoritmer med hjälp av uppgifter på vilket djup-inlärning excel, och de har visat sig vara betydligt bättre i flera fall. “Vi vet något om vad de egenskaper hjärnan bör vara”, förklarar han. “Och vi försöker, i någon mening, att reverse-engineer från dessa egenskaper.”

Boy wonder

Marcus, som föddes i Baltimore, blev fascinerad av sinnet i high school efter att ha läst Den inre jag, en samling essäer om medvetande redigerad av kognitiv forskare Douglas Hofstadter och filosofen Daniel Dennett, liksom Hofstadter är metaforiska bok om sinnen och maskiner, Gödel, Escher, Bach. Runt samma tid som han skrev ett datorprogram för att översätta från Latin till engelska. Svårigheten i uppgiften fick honom att inse att åter-skapa intelligens i maskiner säkert skulle kräva en mycket större förståelse för de fenomen vid arbete inuti det mänskliga sinnet.

Marcus är Latin till engelska program var inte särskilt praktiskt, men det hjälpte övertyga Hampshire College för att låta honom ge dig ut på en grundexamen ett par år för tidigt. Studenter på liten liberal arts school i Amherst, Massachusetts, uppmuntras att utforma sina egna utbildningsprogram. Marcus ägnade sig åt att studera pussel av mänsklig kognition.

Mitten av 1980-talet var en intressant tid för fältet av AI. Det blev delad mellan dem som sökte för att producera intelligenta maskiner genom att kopiera den grundläggande biologi i hjärnan och de som syftar till att efterlikna högre kognitiva funktioner med hjälp av konventionella datorer och programvara. Att tidigt arbeta i AI var baserad på den senare metoden, att använda programmeringsspråk är byggda för att klara logik och symbolisk representation. Fåglar är det klassiska exemplet. Det faktum att fåglar kan flyga kan vara kodad som en bit av kunskap. Då, om en dator fick höra att en starling var en fågel, skulle det dra slutsatsen att starar måste kunna flyga. Flera stora projekt har inletts med syftet med kodning mänsklig kunskap i stora databaser, i hopp om att någon form av komplexa intelligens kan så småningom växa fram.

Men även om vissa framsteg gjordes, strategi visat sig bli allt mer komplex och svårhanterlig. Reglerna har ofta undantag; det är inte alla fåglar kan flyga. Och medan penguins är helt jordbundna, en fågel i en bur och en med en bruten vinge kan inte flyga för mycket olika skäl. Det visade sig vara omöjligt komplicerat att koda alla undantag till dessa regler. Folk verkar att lära sig sådana undantag snabbt, men de datorer som reagerade. (Naturligtvis undantag, bland annat att “eleven” snarare än “onety-en,” kan vara förvirrande för människor också.)

Gary Marcus

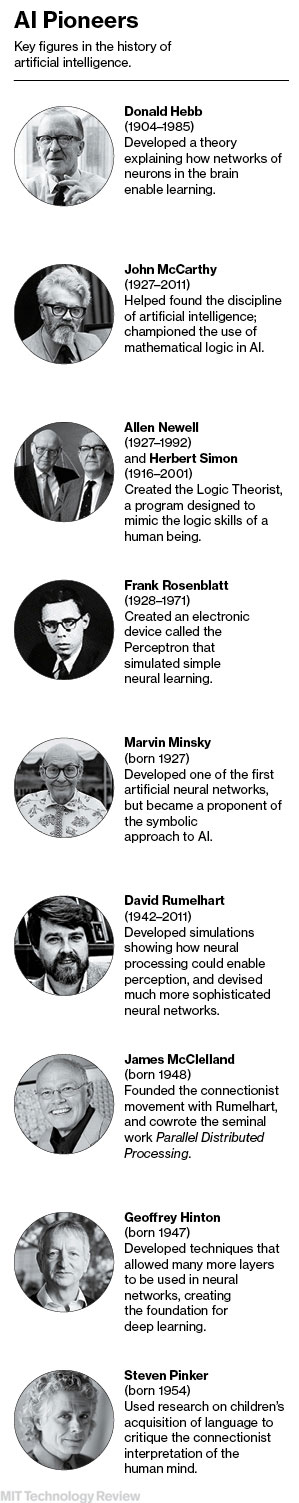

Ungefär samtidigt Marcus var på väg att gå in Hampshire College, en grupp av psykologer kom upp med en strategi som hotade att slå artificiell intelligens upp och ner. På 1940-talet, Donald Hebb hade lagt fram en teori om hur de nerver i hjärnan kan lära sig att känna igen en ingång. Han visade hur de upprepade bränning av nervceller kan stärka deras kopplingar till varandra, vilket ökar sannolikheten för att de skulle skjuta igen när de matas med samma input. Vissa forskare byggt datorer med en liknande design. Men den förmågor av dessa så kallade neurala nätverk var begränsade fram till 1986, när en grupp forskare upptäckte sätt att öka sitt lärande makt. Dessa forskare visade också hur neurala nätverk kan användas för att göra olika saker, från att känna igen mönster i visual data till lärande preteritum av engelska verb. Träna upp dessa nätverk på tillräckligt många exempel, och de utgör de anslutningar som behövs för att utföra dessa uppgifter.

Ringer deras strategi “connectionism,” forskarna hävdade att tillräckligt stort neurala nätverk kan åter-skapa intelligens. Även om deras idéer inte ta över omedelbart, de ledde så småningom till dagens tid av djupt lärande.

Precis som connectionism tar fart, Marcus var att avgöra om att göra sin forskarutbildning, och han deltog i en föreläsning av den berömda kognitiva forskaren Steven mer rosa, då en professor vid MIT. Mer rosa pratade om hur barn lär sig och använder verb, och han hävdade, i motsats till en ren connectionist perspektiv, att de inte verkar få de senaste tempus på verb rent genom att memorera exempel och att generalisera till andra liknande sådana. Mer rosa visade belägg för att barn snabbt upptäcka regler för språk och sedan generalisera. Han och andra anser, i huvudsak, att evolutionen har format de neurala nätverk som finns i den mänskliga hjärnan för att tillhandahålla de verktyg som är nödvändiga för mer sofistikerad intelligens.

En djupt lärande system kan tränas till att känna igen vissa arter av fåglar, men det skulle behöva miljontals exempel på bilder och skulle inte veta något om varför en fågel som inte kan flyga.

Marcus gick mer rosa ‘ s lab vid MIT vid 19, och mer rosa minns honom som en brådmogen student. “Jag tilldelade honom ett projekt för att analysera en enkel ja-ingen hypotes i en liten datamängd av inspelat tal från tre barn, säger han i ett e-post. “Några dagar senare hade han utfört en uttömmande analys på tal av 25 barn som testade ett halvt dussin hypoteser och blev grunden för en stor forskning monografi.”

Som doktorand, Marcus tog ytterligare bevisning till stöd för de mer rosa idéer om lärande och lagt till insikter om sin egen. Han har banat väg för datoriserad analys av stora mängder av kognitiv forskning data, studera tusentals inspelningar av barns tal för att hitta fall där de gjorde fel som “breaked” och “goed” i stället för “bröt” och “gick.” Detta tycktes bekräfta att barn greppa grammatiken och sedan tillämpa dem på nya ord, medan lärande undantag till dessa regler utantill.

På grundval av denna forskning, Marcus började ifrågasätta connectionist tro att intelligens skulle huvudsakligen komma från större neurala nätverk, och han började att fokusera på de begränsningar och påhitt av djupt lärande. En djupt lärande system kan vara utbildade för att känna igen vissa arter av fåglar i bilder eller videoklipp, och att tala om skillnaden mellan de som kan flyga och de som inte kan. Men det skulle behöva se miljontals exempel på bilder för att göra detta, och det skulle inte veta något om varför en fågel som inte kan flyga.

Marcus arbete med barn, i själva verket lett honom till en viktig slutsats. I en bok från 2001, som kallas Algebraiska Sinne, han hävdade att utveckla mänskliga sinnet lär sig både från exempel och genom att skapa regler för vad den har lärt sig. Med andra ord, hjärnan använder något som liknar en djupt lärande system för vissa uppgifter, men också butiker och manipulerar regler om hur världen fungerar så att den kan dra användbara slutsatser från bara några erfarenheter.

Det här ser inte exakt innebära att Geometriska Intelligens försöker efterlikna hur saker och ting att hända i hjärnan. “I en perfekt värld, skulle vi få veta hur barnen göra det,” säger Marcus. “Vi vill veta vad hjärnan kretsar är involverade, de beräkningar som de gör. Men neurovetenskap fortfarande är ett mysterium.” Snarare, han antyder att företaget är med hjälp av en grab bag av tekniker, inklusive de “kompatibla” med djup inlärning, för att försöka återskapa människans lärande.

Sunt förnuft

Arbetet på Geometriska Intelligens är säkert viktigt, eftersom blandning av nya idéer från kognitiv vetenskap och neurovetenskap kommer utan tvekan att vara viktigt för framtiden av artificiell intelligens. Fortfarande, efter ett möte med Marcus, jag kände mig lite som ett litet barn som försöker göra känsla av några okända siffror. Hur kommer allt detta att komma tillsammans? Jag behövde en av Marcus s samarbetspartners för att visa mig en annan bit i pusslet om vad företaget håller på att utveckla.

Zoubin Ghahramani, professor i information engineering vid University of Cambridge i STORBRITANNIEN, är en av grundarna av Geometriska Intelligens. Ghahramani växte upp i Sovjetunionen och Iran innan du flyttar till Spanien och Usa, och även om han är exakt samma ålder som Marcus, han kom på MIT ett år senare. Men eftersom paret delade en födelsedag, det slutade med att de kastar parterna och umgås tillsammans.

Ghahramani är inriktad på att med hjälp av sannolikhet för att göra smartare maskiner. Matematiken bakom detta är komplicerat, men anledningen är enkel: sannolikhet ger ett sätt att hantera osäkerhet eller ofullständig information. Flygande fåglar kan, än en gång, hjälp för att illustrera detta. En sannolikhet-baserade system kan tilldela en hög sannolikhet att begreppet som en fågel klarar av flygning. Sedan, när den får kännedom om att en struts är en fågel, det kommer att anta att det kan förmodligen flyga. Men annan information, till exempel det faktum att en vuxen struts oftast väger mer än 200 pund, som skulle kunna ändra detta antagande, att minska sannolikheten för att en struts kan flyga till nära noll. Detta flexibla tillvägagångssätt som kan genomsyra maskiner med något som liknar en rå form av sunt förnuft, en kvalitet som är mycket viktigt för att den mänskliga intelligensen.

Tala via Skype från sitt kontor i Cambridge, England, Ghahramani föreslår att ett särskilt program som han och Marcus har sitt öga på: utbildning robotar för att hantera komplexa miljöer. I robotics research”, med upplevelser är dyrt, säger han. “Om du vill få en robot att lära sig att gå, eller ett autonomt fordon och att lära sig att köra, kan du inte presentera det med en uppsättning data på en miljon exempel på det är att ramla och bryta eller ha olyckor—som bara inte fungerar.”

Med tanke på att probabilistiska algoritmer och annan teknik i de fungerar på Geometriska Intelligens skulle vara kompatibel med deep learning, är det möjligt att så småningom gillar Google-eller Facebook kommer att förvärva företaget och lägg till det att dess totala AI portfölj. Och trots att Marcus kritik av connectionism och djup-inlärning feber, jag har en föraning om att han skulle vara helt nöjd med ett sådant resultat.

Även om det händer, kommer det att vara betydande om Marcus kan visa att den mest mirakulösa lärande system som vi vet—det mänskliga sinnet—är nyckeln till framtiden för artificiell intelligens. Marcus ger mig ett annat exempel på hans sons duktighet. “Min fru frågade honom:” Vilka av dina vänner djuren kommer till skolan i dag?’” Marcus säger. “Och han säger,” Stor Kanin, eftersom Björnen och Näbbdjuret är att äta.’ Då min fru går tillbaka in i hans rum och säker nog, de leksaker som finns på en stol ‘att äta.’”

Marcus underverk som hans två år gamla kan resonera om regler för mänskligt beteende—inse att du är antingen att gå till skolan eller gör något annat—och skapa en helt ny mening baserat på hans växande förståelse för hur språk fungerar. Efter en paus, och ett leende, tillägger han: “Tja, du visar mig den AI-system som kan göra det.”

0 kommentarer