Een team van onderzoekers van de Universiteit van Cambridge, is het lenen van een aantal van de technieken die gebruikt worden in autonome voertuigen om te leren uw telefoon om te navigeren, zelfs wanneer het geen toegang tot de positionering van de informatie, zoals een GPS-signaal.

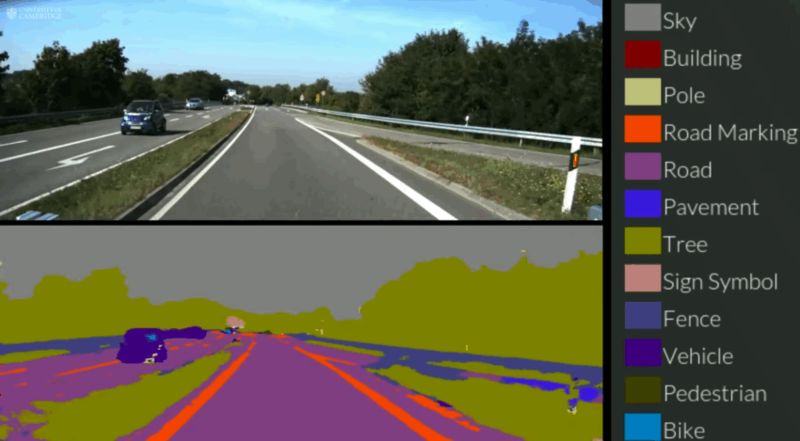

In feite, het team heeft twee nieuwe stukjes software die draaien op mobiele telefoons, maar denk een beetje zoals onbemande auto ‘ s. De eerste, genaamd SegNet, kan met beelden van een straatbeeld van een smartphone en het classificeren, sorteren van voorwerpen in 12 verschillende categorieën, zoals wegen, borden, voetgangers, gebouwen en fietsers. Je ziet het in actie boven. Het team legt uit hoe het werkt:

SegNet leert door zijn voorbeeld, het werd ‘getraind’ door een ijverige groep van Cambridge studenten, die handmatig geëtiketteerd elke pixel in elk van 5000 beelden, met elk beeld neemt ongeveer 30 minuten in beslag. Zodra de etikettering klaar was, hebben de onderzoekers vervolgens duurde twee dagen aan het ‘trainen’ van het systeem, voordat het in actie.

Het team beweert “het kunnen omgaan met licht, schaduw en’ s avonds omgevingen, en momenteel etiketten meer dan 90% van de pixels goed.”

Het tweede systeem maakt gebruik van beelden uit het straatbeeld te onderscheiden waar de telefoon is, met behulp van de geometrie van gebouwen en straatmeubilair te onderscheiden locatie. Het systeem heeft tot nu toe getest in het centrum van Cambridge, waar het is aangetoond dat het “veel nauwkeuriger dan GPS.” Het is zeer vergelijkbaar met de manier waarop de meeste autonome auto ‘ s, waaronder die van Google, vergelijken voelde gegevens naar bestaande voorafgaande maps om zich te oriënteren op de weg.

Denk niet dat uw telefoon zal plotseling veranderen uw auto in een autonoom voertuig, dat wel. “Op de korte termijn, dat we meer kans op dit soort van systeem op een binnenlandse robot – zoals een robot stofzuiger, bijvoorbeeld,” aldus Roberto Cipolla, één van de onderzoekers die werkzaam zijn op het project, in een persbericht. Moet ergens beginnen, eh?

Gesponsord

[Cambridge University]