Bilde: Universitetet i Albany SUNY

Bilde: Universitetet i Albany SUNY

Den hastigheten som deepfake videoer er fremme er både imponerende og dypt urovekkende. Men forskere har beskrevet en ny metode for å oppdage en “avslørende tegn” av disse manipulert videoer, kart som en persons ansikt på kroppen til en annen. Det er en feil selv den gjennomsnittlige person ville merknad: manglende blinker.

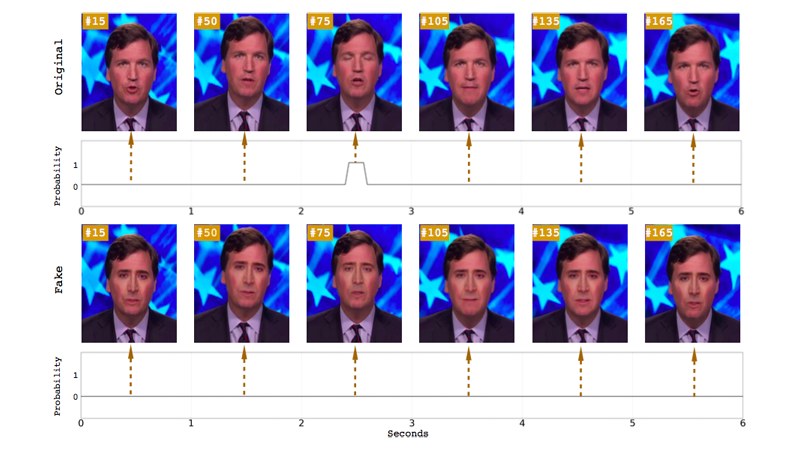

Forskere fra Universitetet i Albany SUNY ‘ s computer science department nylig publisert en artikkel med tittelen “I Ictu Oculi: å Utsette AI Generert Falske Ansikt Videoer ved å Oppdage Eye Blinker.” Papiret detaljer hvordan de kombineres to nevrale nettverk til mer effektivt å utsette syntetisert ansikt videoer, som ofte overse “spontan og ufrivillig fysiologiske aktiviteter som å puste, pulsen og øyebevegelser.”

Forskerne oppmerksom på at den betyr å hvile blink pris for mennesker er 17 blink per minutt, noe som øker til 26 blink per minutt når noen snakker, og reduseres til 4,5 blink per minutt når noen leser. Forskerne legger til at disse skillene er verdt å betale oppmerksomhet til “, siden mange av talking head politikere er nok å lese når de blir filmet.” Så når en gjenstand i en video som ikke blinker i det hele tatt, det er en enkel fortelle at opptakene ikke er legit.

Det er en grunn til fag i deepfake videoer ikke blink: Mest trening datasett matet til nevrale nettverk inkluderer ikke lukkede øyne-bilder, bilder av folk som legges ut på nettet generelt bilde av øynene åpne. Det er følgeskader, gitt noen har behov for å samle inn masse bilder av en person for å opprette en deepfake av dem, og dette kan gjøres gjennom en open-source ” bilde-skraping verktøy som griper offentlig tilgjengelige bilder av target online.

Forrige papirer har pekt på mangel på øye-blinker som en måte å oppdage deepfakes, men Universitetet i Albany forskerne sier at deres system er mer nøyaktig enn tidligere foreslått oppdagelse metoder. Tidligere studier brukt øye aspect ratio (EAR)) eller en convolutional nevrale nettverk-basert (CNN) classifiers å oppdage hvis øyne var åpne eller lukket. I dette tilfellet, forskere kombinert CNN-basert metode med en rekursiv nevrale nettverk (RNN), en tilnærming som vurderer forrige øye stater i tillegg til individuelle bilder av video.

I motsetning til et rent CNN modell, sier forskerne deres langsiktige Tilbakevendende Convolutional Nettverk (LRCN) tilnærming kan “effektivt forutsi øye staten, slik at det er mer jevn og nøyaktig.” I henhold til papiret, er denne tilnærmingen har en nøyaktighet på 0.99, i forhold til CNN ‘ s 0.98 og ØRE er 0.79.

I det minste, at forskerne funn signal om at maskinen læring fremskritt som muliggjorde etableringen av disse ultrarealistic falske videoer kunne ha en hånd i å utsette dem. Men deepfakes er fortsatt å forbedre urovekkende raskt. For eksempel, et nytt system som kalles Dyp Video Portretter lar en kilde skuespiller manipulere stående video av noen andre, og det gir mulighet for en rekke fysiologiske signaler, inkludert blinkende og blikk.

Det er betryggende å se at eksperter på utkikk etter måter å få øye på ekte videoer fra falske, spesielt siden dårlige skuespillere vil fortsette å misbruke teknologien til å utnytte kvinner og potensielt forhånd spredning av falske nyheter. Men det gjenstår å se om disse to metodene vil outpace en rask utvikling av deepfake tech. Og, mer concerningly, hvis allmennheten vil selv ta deg tid til å lure på om videoen de ser er ekte eller produkt av en internett-troll.

“I min personlige mening, det viktigste er at allmennheten har til å være oppmerksom på de muligheter moderne teknologi for video generasjon og redigering,” Michael Zollhöfer, gjesteprofessor ved Stanford University som bidro til å utvikle Dyp Video Portretter, skrev i et blogginnlegg. “Dette vil gjøre dem i stand til å tenke mer kritisk om video-innhold, de spiser hver dag, spesielt hvis det er ingen bevis på opprinnelse.”

[h/t Registeret]