Mere end 50 førende eksperter inden for udvikling af kunstig intelligens bekendtgjort sin hensigt om at boykotte Korean Institute of advanced technology (KAIST) er en prestigefyldt og førende undervisning og forskning University i Sydkorea for etablering af et laboratorium for udvikling af våben, ved hjælp af kunstig intelligens. Det sagde de i et åbent brev.

Forargelse af eksperter inden for AI blev kaldt, og KAIST har underskrevet en aftale med virksomheden Hanwha våben Systemer, som ifølge forskellige kilder, som er involveret i udviklingen af kraftfulde våben, herunder blandt andet har klyngebomber, er forbudt i henhold til FN-Konventionen om klyngeammunition (Sydkorea i denne Traktat).

“Mens de Forenede Nationer, der er involveret i drøftelser om, hvordan indeholde trussel mod den internationale sikkerhed, som Autonome våben, det er en beklagelig kendsgerning, at en så prestigefyldt Universitet som KAIST, på udkig efter måder til at fremskynde arms race gennem udvikling af disse nye typer af våben,” skriver eksperter af AI i det åbne brev.

“Vi er derfor offentligt at erklære, at vi vil boykotte alle former for samarbejde med alle afdelinger af KAIST så lang tid som Formand for KAIST ikke give sikkerhed for, at centret ikke vil engagere sig i udviklingen af Autonome våben, hvis funktion er mulig uden menneskelig intervention”.

KAIST råder over nogle af de bedste i verden af robot-og science laboratory: det udfører forskning og udvikling af forskellige avancerede teknologier, lige fra flydende batterier og medicinsk udstyr.

Lederen af KAIST Shin sung-Chul sagde, at han var ked af beslutningen om at boykotte, og tilføjer, at Instituttet ikke kommer til at skabe killer robotter.

“Som en akademisk institution, vi sætter pris på den menneskerettigheder og etiske standarder. KAIST ikke kommer til at gennemføre forskningsaktiviteter i strid med principperne om menneskelig værdighed, herunder at udvikle Autonome våben, der ikke kræver menneskelig kontrol,” siger Shin sung-Chol i sin officielle erklæring om boykot.

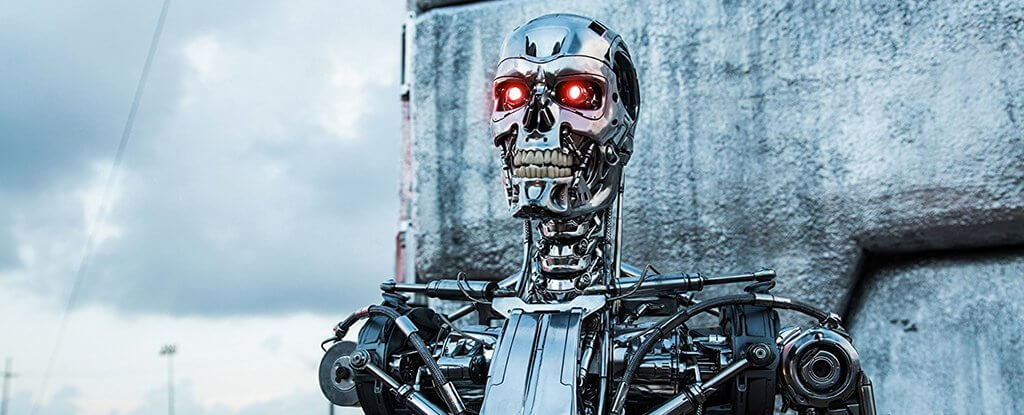

I betragtning af den hurtige udvikling af hardware og software, og mange eksperter er bekymrede over, at før eller senere vil vi skabe noget, der ikke vil være i stand til at kontrollere. Elon Musk, Steve Wozniak, nyligt afdøde Stephen Hawking og mange andre fremtrædende personligheder inden for IT-teknologier på det tidspunkt, opfordrede regeringer og FN til at indføre restriktioner på udvikling af våbensystemer, AI.

Ifølge mange, hvis vi kommer til missiler og bomber, hvis funktion vil være muligt uafhængigt af menneskelig kontrol, kan konsekvenserne være katastrofale, især hvis en sådan teknologi, der faldt i de forkerte hænder.

“Oprettelse af Autonome våben vil føre til, at den tredje revolution i militære Anliggender. Denne teknologi vil give mulighed for en hurtigere, ødelæggende og omfattende militær konflikt”, — forfatterne af det åbne brev.

“Disse teknologier, der har potentiale til at blive et våben af terror. Diktatorer og terrorister kan bruge dem mod uskyldige befolkninger, ignorerer eventuelle etiske overvejelser. Dette er en ægte Pandora ‘ s box, som ligger tæt, hvis åbne, ville være næsten umuligt.”

Medlemmer af FN ‘ s kommer til at holde næste uges møde, hvor man vil drøfte spørgsmål i relation til forbuddet mod dødelige Autonome våben, der kan dræbe uden menneskelig indgriben. Af den måde, vil det allerede være langt fra det første møde, men den diskussion er endnu ikke kommet til nogen aftale. Et af de problemer, der står i vejen for at gøre noget konkret afgørelser, er, at nogle lande bare ikke tankerne om udvikling af sådanne teknologier, fordi de kan øge deres militære potentiale. Blevet en anstødssten og private virksomheder, der aktivt at modstå kontrol af regeringer til udvikling af deres egne modeller af systemer af kunstig intelligens.

Det ser ud til, at mange er enige med det faktum, at killer robotter er dårlige. Men, for at tage eventuelle beslutninger om, hvad de skal gøre med deres udvikling, det virker stadig ikke. Det er muligt, at udvikling af nye våbensystemer, som har planer om at tage KAIST, vil gøre flere parter til at deltage i den nødvendige diskussion af problemet.

Mange forskere opfordres til oprettelse af henstilling retningslinjer for udvikling og implementering af AI-system. Dog, en stor sandsynlighed for, at, selv i nærværelse af disse ville være meget vanskeligt at sikre, at hver part følge dem.

“Vi er besat med våbenkapløb, som ingen ønsker. KAIST handlinger vil kun accelerere våbenkapløb. Vi kan ikke tolerere det. Jeg håber, at denne boykot vil øge vigtigheden af behovet for at drøfte sagen i FN på mandag,” siger Professor på kunstig intelligens, af den Australske University of New South Wales Toby Walsh, også har underskrevet brevet.

“Dette er en klar appel til fællesskabet, der er involveret i udviklingen af teknologier for kunstig intelligens og robotteknologi — ikke for at støtte udviklingen af Autonome våben. Alle andre institutioner, som ønsker at åbne lignende øvelser bør tænke to gange.”

En sydkoreansk Institut har varslet en boykot for udvikling af forsvarsmateriel på grundlag af AI

Nikolai Khizhnyak