Den berømte fysiker Richard Feynman engang sagde: “Hvad jeg ikke kan skabe, kan jeg ikke forstå. Lær at løse hvert enkelt problem, der allerede er løst”. Omfanget af neuroscience, som i stigende grad vinder indpas, tog Hans ord til hjerte. For neuroforskere, teoretikere nøglen til at forstå, hvordan den intelligens, vil være sin fritid, indersiden af din computer. Neuron til neuron, at de forsøger at genoprette de neurale processer, der giver anledning til tanker, erindringer og følelser. At have en digital hjerne, og forskere er i stand til at teste vores nuværende teori om viden eller til at udforske de parametre, der fører til forstyrrelse af hjernens funktion. Som foreslået af filosoffen Nick Bostrom af Oxford University, en efterligning af den menneskelige bevidsthed er et af de mest lovende (og hårdt) måder at genskabe — og overgå — menneskelige opfindsomhed.

Der er kun ét problem: vores computere kan ikke håndtere den parallelle karakter af vores hjerner. I polutorachasovom organ, snoet mere end 100 milliarder neuroner, og milliarder af synapser.

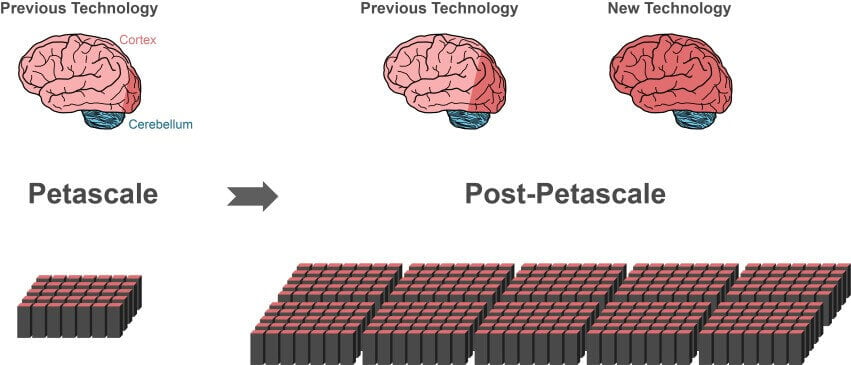

Selv de kraftigste supercomputere i dag står bag disse vægte, som de K computer af Avancerede Institut for computational science i Kobe, Japan, kan processen ikke mere end 10% af neuroner og deres synapser i cortex.

En del af slæk i forbindelse med software. Bliver det hurtigere computer udstyr, jo mere de algoritmer, der bliver grundlag for en fuldstændig simulering af hjernen.

I denne måned en international gruppe af forskere har fuldstændig ændret struktur af populære algoritme for simulation ved at udvikle en stærk teknologi, der radikalt reducerer beregningen tid og hukommelse. Den nye algoritme er kompatibel med forskellige former for it-udstyr, fra bærbare computere til supercomputere. Når fremtidens super-computere kommer på scenen — og de er 10-100 gange mere kraftfuld end en aktuel — algoritmen er umiddelbart anvendes på disse monstre.

“Takket være ny teknologi kan vi bruge den voksende parallelitet i moderne mikroprocessorer er meget bedre end før,” siger undersøgelse forfatter Jacob Jordan, af forskningscenter for Julia i Tyskland. Arbejdet blev offentliggjort i Grænser i Neuroinformatics er.

“Dette er et afgørende skridt i retning af skabelsen af teknologi til at opnå simulering af netværk i hele hjernen,” skriver forfatterne.

Problemet med skala

Moderne supercomputere består af hundredvis af tusindvis af underdomæner noder. Hver node indeholder flere behandling centre, som kan støtte en håndfuld af virtuelle neuroner og deres forbindelser.

Det største problem i simuleringen af hjernen er, hvordan man effektivt repræsenterer millioner af neuroner og deres forbindelser i disse centre, for at spare på tid og kraft.

En af de mest populære algoritmer til simulering — Hukommelse-Skik Model. Før forskerne simulere ændringer i deres neurale netværk, skal du først oprette alle disse neuroner og deres forbindelser i den virtuelle hjernen ved hjælp af algoritmen. Men her er hagen: for hvert par af neuroner, model, der gemmer alle oplysninger om forbindelser på hver node, der er den modtagende neuron — postsynaptiske neuron. Med andre ord, den presynaptic neuroner, der sender elektriske impulser, der råber ind i det tomrum, den algoritme, der skal bestemme, hvor en bestemt meddelelse, ved udelukkende at se på den modtagende neuron og de data, der er gemt i knude.

Det kan synes mærkeligt, men denne model giver mulighed for alle knuder til at bygge sin del af arbejdet i neurale netværk i parallel. Dette reducerer dramatisk download-tid, hvilket til dels forklarer populariteten af denne algoritme.

Men som du måske har gættet, at der er alvorlige problemer med skalering. Afsenderen node sender en besked til alle væld af neurale noder. Dette betyder, at modtager hver node skal sortere hver besked i netværket — også dem, der er designet til enheder, der er beliggende i andre noder.

Dette betyder, at en stor del af meddelelsen er kasseret ved hver node, specielt fordi der er ingen neuron, som den er rettet til. Forestil dig, at postvæsenet sender alle medarbejdere i land for at udføre en ønsket meddelelse. Crazy ineffektive, men det virker som princip model af brug af hukommelse.

Problemet bliver mere alvorlige med væksten i størrelsen af de simulerede neurale netværk. Hver node er behov for at afsætte plads til den hukommelse, “address book”, der viser alle neurale indbyggere og deres indbyrdes relationer. I omfanget af milliarder af neuroner, “address book” bliver et kæmpe sump af hukommelse.

Størrelsen eller kilde

Forskere har knækket problemet ved at tilføje algoritmen… indekset.

Her er hvordan det virker. Den modtagende knuder indeholder to oplysninger. Den første er en database, som gemmer oplysninger om alle de neuroner-afsendere at oprette forbindelse til noder. Da synapser er af forskellige størrelser og typer, som varierer i hukommelse, den database, der sorterer dine oplysninger, afhængigt af de typer af synapser dannet af neuroner i knude.

Denne indstilling er meget forskellige fra tidligere modeller, hvor foreninger, blev sorteret fra det kommende kilde af neuroner, og den type af synapser. På grund af dette, vil node ikke længere nødt til at støtte, “address book”.

“Størrelsen af den datastruktur, der således ophører med at afhænge af det samlede antal neuroner i netværket,” forklarer forfatterne.

Den anden blok gemmer data om den faktiske forbindelser mellem den modtagende knude, og afsenderen. Som den første enhed, der organiserer data i henhold til den type af synapser. I hver type af synapse er adskilt fra datakilden (afsendelse neuron).

Således, denne algoritme er bestemt til sin forgænger: i stedet for at gemme alle forbindelsen information i hver knude, der modtager knudepunkter gemme kun de data, der svarer til virtuelle neuroner i dem.

Forskerne også gav hver af de sende neuron til målet adresse bog. Under transmission, er data opdelt i stykker, hvert fragment, der indeholder kode, postnummer, sender det til den rette modtager noder.

Hurtigt og smart

Ændring arbejdet.

Under test af den nye algoritme viste sig meget bedre end deres forgængere, i form af skalerbarhed og hastighed. På supercomputer JUQUEEN i Tyskland, den algoritme, der arbejdede med 55% hurtigere end de tidligere modeller på tilfældige neurale netværk, for det meste takket være sin enkle ordning for overførsel af data.

I et netværk størrelsen af halvdelen en milliarder neuroner, for eksempel, simulering af en anden af biologiske hændelser tog omkring fem minutter, og arbejde gang på JUQUEEN nye algoritme. Model-forgængere tog i seks gange mere tid.

Som forventet, flere skalerbarhed tests viste, at den nye algoritme er meget mere effektive i håndteringen af store netværk, da det reducerer behandlingstiden af titusinder af overførsler af data tre gange.

“Fokus er nu på at fremskynde simulering i tilstedeværelsen af forskellige former for netværk plasticitet,” konkluderede forfatterne. Med dette i tankerne, endelig, digital menneskelige hjerne kan være inden for rækkevidde.

Den nye algoritme, der har bragt os til en fuldstændig simulering af hjernen

Ilya Hel