Det verkar som att datorer kan redan nu läsa våra sinnen. Google autocomplete vänförslag på Facebook och riktade reklam som Dyker upp i din webbläsare, ibland gör man tänka: hur fungerar det? Vi är sakta men säkert på väg i riktning av datorer för att läsa våra sinnen, och en ny studie från Kyoto, Japan, var helt klart ett steg i denna riktning.

Ett team av forskare från Kyotos Universitet används en djup neurala nätverk för att läsa och tolka människors tankar. Låter otroligt? I själva verket kan en sådan inte för första gången. Skillnaden är att tidigare metoder och resultat — var enklare, de hade dekonstrueras bild-och pixel, och de grundläggande kretsar. Ny teknik, som kallas “deep image återuppbyggnad”, ligger utanför den binära pixlar och ger forskare med förmåga att avkoda bild med flera lager av färg och konsistens.

“Vår hjärna bearbetar visuell information genom att extrahera hierarkiska drag av olika nivåer eller komponenter av olika komplexitet, säger Yukiyasu Kamitani, en av forskarna bakom studien. “Dessa neurala nätverk eller modell AI kan användas som en proxy för den hierarkiska strukturen i den mänskliga hjärnan”.

Studien ägde rum för 10 månader. I studien, tre personer studerat bilder av tre olika kategorier: naturligt fenomen (djur eller människor), artificiell geometriska former och bokstäver i alfabetet.

Hjärnans aktivitet mättes genom observatörer antingen medan du tittar på bilder, eller efter. För att mäta hjärnans aktivitet efter att ha tittat på bilderna, folk är helt enkelt bad att tänka på de bilder som de visas.

Registrerad aktivitet sedan matas till det neurala nätverket, som är “dekrypteras” data och använde dem för att skapa sina egna tolkningar och tankar av människor.

På människor (och, faktiskt, alla däggdjur) syncentrum ligger på baksidan av hjärnan, nackloben, vilket är över lillhjärnan. Aktivitet i visuella cortex, mätt med hjälp av funktionell magnetresonanstomografi (fMRI), som förvandlades till den hierarkiska funktioner med djupa neurala nätverk.

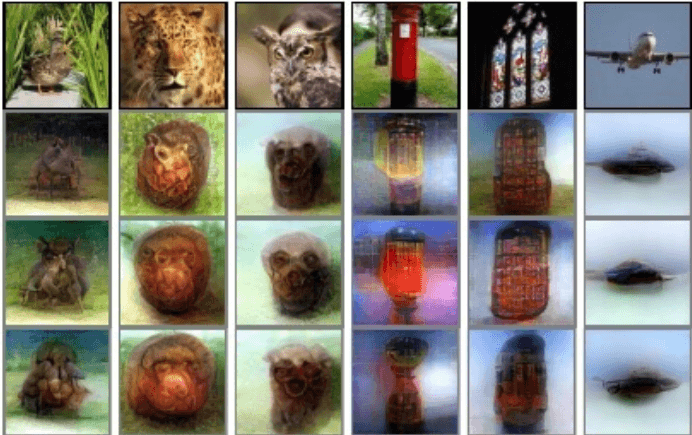

Börjar med en random bild, nätverket är iterativt optimerar pixel värdena i den här bilden. Funktioner inledning till neurala nätverk bilden bli liknande den har avkodats från hjärnans aktivitet.

Viktigast av allt, den modell som forskarna har utbildats med hjälp av endast naturliga bilder (människor eller natur), men jag lärde mig att bygga en konstgjord form. Detta innebär att modellen verkligen är “skapad” bild, från hjärnans aktivitet, och inte jämföra denna verksamhet med befintliga exempel.

Inte överraskande, den modell som hade svårigheter med avkodning av hjärnans aktivitet när människor ombeds att komma ihåg den bilden, och det är lättare när de är direkt sett dessa bilder. Våra hjärnor kan inte komma ihåg alla detaljer som sett bilder, så mycket minnen kommer alltid att vara vag.

Den rekonstruerade bilder från studien behålla vissa likheter med det ursprungliga bilder ses av deltagarna, men för det mesta verkar vara som minimalt detaljerad blots. Men tillförlitligheten av tekniken kommer bara att öka, och med den kommer att expandera och möjliga tillämpningar.

Tänk att “instant konst”, när du kan skapa ett konstverk, bara att lägga fram det i mitt huvud. Eller om AI kommer att registrera din aktivitet i hjärnan medan du sover, och sedan skapa dina drömmar för analys? Förra året helt förlamade patienter att kommunicera med sina familjer genom hjärna-dator-gränssnitt.

Det finns massor av möjliga tillämpningar av den modell som används i Kyoto studie. Men hjärna-dator-gränssnitt kan också återskapa de fasansfulla bilderna, om vi lär oss att rätt tolka hjärnans aktivitet. Kostnaden för misstag i händelse av fel läsa tankar kan vara för hög.

Med allt detta, det Japanska företaget är inte ensam i sin strävan att skapa en mind-behandlingen AI. Elon Musk grundades Neuralink att skapa hjärna-dator-gränssnitt mellan människor och datorer. Kärnan är att arbeta på att skapa marker som kan läsa och skriva neural kod. Tankeläsning är långsamt växande.

Japansk neurala nätverk är lärt sig att “läsa tankar”

Ilya Hel