Billede: University at Albany SUNY

Billede: University at Albany SUNY

Den hastighed, hvormed deepfake videoer er fremme er både imponerende og dybt foruroligende. Men forskere har beskrevet en ny metode til påvisning af en “afslørende tegn” af disse manipulerede videoer, der kort en persons ansigt på kroppen af en anden. Det er en fejl, selv den gennemsnitlige person ville lægge mærke til: en mangel på at blinke.

Forskere fra University at Albany SUNY computer science department for nylig udgivet et papir med titlen “I Ictu Oculi: Udsætte AI Genereret Falske Ansigt Videoer ved at registrere Øje med at Blinke.” Papiret i detaljer, hvordan de kombinerede to neurale netværk til mere effektivt at udsætte syntetiseret ansigt videoer, som ofte overser “spontane og ufrivillige fysiologiske aktiviteter såsom vejrtrækning, puls og øjenbevægelser.”

Forskerne bemærk, at den gennemsnitlige hvilepuls blink sats for mennesker er 17 blink per minut, hvilket stiger til 26 blink per minut, når nogen taler, og falder til 4.5 blink per minut, når nogen læser. Forskerne tilføjer, at disse sondringer er værd at være opmærksom på “, da mange af de taler-hoved politikere er nok at læse, når de bliver filmet.” Så når et motiv i en video ikke blinker ved alle, det er et nemt fortælle, at optagelserne ikke er legit.

Der er en grund emner i deepfake videoer ikke blinker: de Fleste træning datasæt fed at neurale netværk ikke omfatte lukkede øjne fotos, billeder af mennesker, lagt online generelt skildrer deres øjne åbne. Der er følgeskader, da nogen har brug for at indsamle masser af fotos af en person med henblik på at skabe en deepfake af dem, og dette kan gøres gennem en open-source-foto-skrabning værktøj, som griber offentligt tilgængelige billeder af target online.

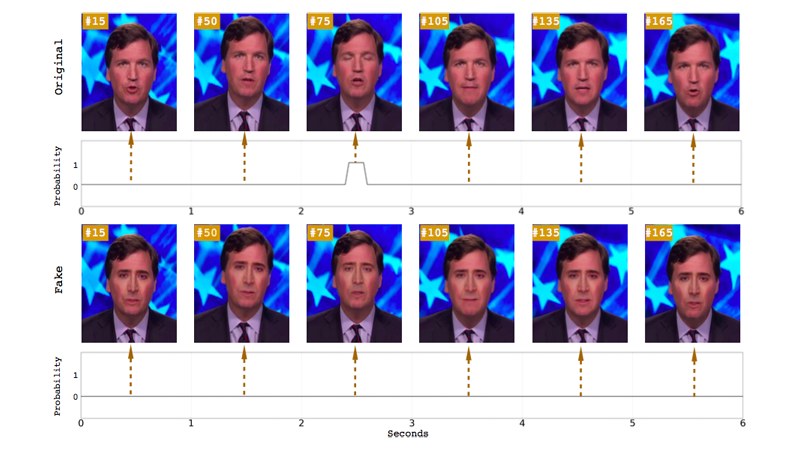

Tidligere papirer har peget på, at manglen på eye-blinker som en måde at opdage deepfakes, men Universitetet i Albany forskere siger, at deres system er mere præcise end tidligere foreslået metoder til påvisning. Tidligere undersøgelser anvendes øje aspekt ratio (ØRE) eller en convolutional neurale netværk-baseret (CNN) kriterier for klassificering til at opdage, hvis øjne var åbne eller lukkede. I dette tilfælde, at forskerne kombinerede CNN-baseret metode med en rekursiv neurale netværk (RNN), en tilgang, der mener, at tidligere øjet bestemmer desuden, at enkelte billeder i en video.

I modsætning til en rent CNN modeller, forskerne siger, at deres langsigtede Tilbagevendende Convolutional Netværk (LRCN) tilgang kan “effektivt forudsige øje stat, sådan at det er mere glat og præcis.” Ifølge avisen, at denne tilgang har en nøjagtighed, 0.99, i forhold til CNN ‘ s 0.98, og ØRET er 0,79 euro.

I det mindste, at forskernes resultater signal om, at machine learning fremskridt, der muliggjorde oprettelsen af disse ultrarealistic falske videoer, kunne have en hånd, for at afsløre dem. Men deepfakes er stadig forbedring alarmerende hurtigt. For eksempel, et nyt system, der hedder Dyb Video-Portrætter lader en kilde skuespiller manipulere portræt-video af en anden person, og det giver mulighed for en række fysiologiske signaler, herunder blinkende og et øje blik.

Det er betryggende at se, eksperter på udkig efter måder at få øje på reelle videoer fra falske dem, især da dårlig aktører vil fortsætte med at misbruge den teknologi til at udnytte kvinder, og potentielt kan fremme spredning af falske nyheder. Men det er fortsat uvist, om disse metoder til påvisning vil overhale den hurtige udvikling af deepfake tech. Og, mere concerningly, hvis offentligheden vil endda tage sig tid til at spekulere på, om den video, de ser, er ægte eller produkt af en internet-trold.

“I min personlige mening, det vigtigste er, at offentligheden har krav på at være klar over mulighederne i moderne teknologi til video-produktion og redigering,” Michael Zollhöfer, en visiting assistant professor ved Stanford University, der hjalp med at udvikle Dybt Video-Portrætter, skrev i et blogindlæg. “Dette vil sætte dem i stand til at tænke mere kritisk om videoens indhold, de indtager hver dag, især hvis der ikke er bevis for oprindelse.”

[h/t Registeret]