Der berühmte Physiker Richard Feynman sagte einmal: «Was ich nicht schaffen kann, verstehe ich nicht. Erfahren Sie, wie lösen jedes Problem, das bereits gelöst wurde». Der Bereich der Neurowissenschaften, die zunehmend an Dynamik gewinnt, hat die Worte von Feynman nah am Herzen. Für Neurowissenschaftler-Theoretiker der Schlüssel zum Verständnis dafür, wie Intelligenz funktioniert, wird seine Wiederherstellung im inneren des Computers. Neuron für Neuron, Sie versuchen, die neurale Prozesse, die Anlass zu den Gedanken, Gedächtnis oder Gefühle. Mit digitalen Gehirn, die Wissenschaftler in der Lage, Besuche unsere gegenwärtige Erkenntnistheorie oder erkunden Sie die Optionen, die führen zu einer Störung der Gehirnfunktion. So glaubt der Philosoph Nick Бостром von der Universität Oxford, die Nachahmung des menschlichen Bewusstseins ist einer der vielversprechendsten (und mühsamen) Methoden neu — und übertreffen — menschliche Einfallsreichtum.

Es gibt nur ein Problem: unsere Computer nicht umgehen können mit der parallelen Natur unseres Gehirns. In полуторакилограммовом Organ verflochten mehr als 100 Milliarden Neuronen und Billionen von Synapsen.

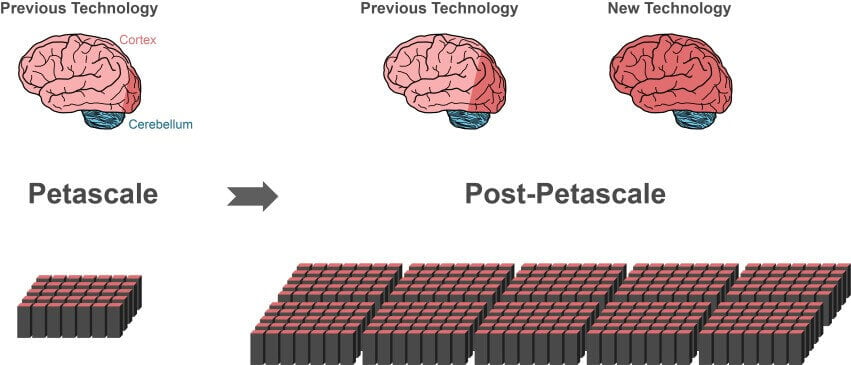

Selbst die leistungsfähigsten Supercomputer heute hinter diesen Größenordnungen solche Maschine, wie ein Computer, der Vorderste K Institut für informatik in Kobe, Japan, verarbeiten können nicht mehr als 10% der Neuronen und deren Synapsen im Cortex.

Zum Teil werden diese durchschlagen Softwareproblem. Je schneller wird die Rechenleistung der Geräte, desto häufiger algorithmen sind die Basis für eine vollständige Simulation des Gehirns.

In diesem Monat eine internationale Gruppe von Wissenschaftlern vollständig überarbeitet, die Struktur der beliebten Simulation des Algorithmus, indem Sie eine leistungsfähige Technologie, die radikal reduziert Rechenzeit und Speichernutzung. Der neue Algorithmus ist kompatibel mit allen Arten von Computing-Geräten, vom Notebook bis Supercomputer. Wenn die zukünftigen Supercomputer wird auf der Bühne — und Sie werden in 10-100 mal stärker modernen — Algorithmus wird sofort in Urlaub auf diese Monster.

«Dank der neuen Technologie können wir die wachsende Parallelität von modernen Mikroprozessoren viel besser als früher», sagt der Autor der Studie, Jacob Jordan von Jülicher Forschungszentrums in Deutschland. Die Arbeit wurde in Frontiers in Neuroinformatics.

«Dies ist ein entscheidender Schritt in Richtung der Schaffung eines Verfahrens zur Erreichung der Simulation von Netzwerken in den mastben des Gehirns», schreiben die Autoren.

Das Problem des Maßstabs

Moderne Supercomputer bestehen aus Hunderttausenden von Unterdomänen — Knoten. Jeder Knoten enthält eine Vielzahl von Bearbeitungszentren, die eine Handvoll virtueller Neuronen und deren verbindungen.

Das Hauptproblem in der Simulation des Gehirns ist, wie wirkungsvoll Millionen Neuronen und Ihre verbindungen in diesen Centern, so sparen Sie Zeit und Energie.

Einer der beliebtesten algorithmen-Simulation — Memory-Usage Model. Bevor die Wissenschaftler simulieren die Veränderungen in Ihren neuronalen Netzwerken, müssen Sie zuerst zu erstellen alle diese Neuronen und Ihre verbindungen in einem virtuellen Gehirn mit Hilfe eines Algorithmus. Aber hier ist der Haken: für jedes paar von Neuronen Modell speichert alle Informationen über die verbindungen in jedem Knoten, in dem sich das empfangende Neuron — постсинаптический Neuron. Mit anderen Worten, das praesynaptische Neuron, sendet die elektrischen Impulse, schreit in die leere; der Algorithmus muss herausfinden, Woher bestimmte Nachricht, den Blick ausschließlich auf das empfangende Neuron und gespeicherte Daten in seine Website.

Es mag seltsam erscheinen, aber ein solches Modell ermöglicht es, alle Knoten zu bauen, die Ihren Teil der Arbeit im neuronalen Netz parallel. Es drastisch reduziert die Ladezeiten, was teilweise erklärt die Popularität solcher Algorithmus.

Aber wie Sie vielleicht schon erraten haben, es gibt ernsthafte Probleme mit Skalierung. Knoten Absender sendet seine Nachricht an alle empfangenden neuronaler Knoten. Das bedeutet, dass jeder empfangende Knoten Sortieren muss jede Nachricht im Netzwerk — auch diejenigen, die für Neuronen, die sich in anderen Knoten.

Dies bedeutet, dass ein großer Teil der Nachrichten in den einzelnen Knoten verworfen, weil speziell darin kein Neuron-Empfänger. Stellen Sie sich vor, dass die post sendet alle Mitarbeiter des Landes zugeschrieben, die gewünschte Nachricht. Verrückte Ineffizienz, aber genau so funktioniert das Prinzip-Modell der Speichernutzung.

Das Problem wird ernster mit dem Wachstum der Größe der simulierten neuronalen Netzwerk. Jedem Knoten muss zum reservieren von Speicherplatz für die Speicherung des «Adressbuch», in dem sind alle Bewohner und Ihre neuronale Kommunikation. Im Maßstab von Milliarden Nervenzellen «Adressbuch» wird zu einem riesigen Sumpf Speicher.

Größe oder Quelle

Wissenschaftler gehackt Problem, indem in Algorithmus… index.

Hier ist, wie es funktioniert. Die Knoten enthalten zwei Arten von Informationen. Die erste ist eine Datenbank, in der Daten gespeichert über alle Neuronen-die Absender von Nachrichten, die eine Verbindung mit dem Knoten. Da Synapsen kommen in verschiedenen Größen und Typen, die unterscheiden sich in der Verwendung des Speichers, diese Datenbank auch sortiert Ihre Informationen in Abhängigkeit von den Typen von Synapsen, die Neuronen im Knoten.

Diese Einstellung bereits deutlich von früheren Modellen, bei denen die Daten über die verbindungen сортировались Quelle für eingehenden Neuronen und nicht durch die Art der Synapse. Wegen dieser Knoten nicht mehr zu unterstützen «Adressbuch».

«Die Größe der Datenstruktur somit nicht mehr abhängig von der Gesamtzahl der Neuronen im Netz», erklären die Autoren.

Die zweite Einheit speichert Informationen über die aktuellen verbindungen zwischen den empfangenden Knoten und Absender von Nachrichten. Ähnlich der ersten Einheit, er organisiert die Daten nach Typ der Synapse. In jeder Art von Synapse Daten getrennt von der Quelle (der sendende Neuron).

Daher ist dieser Algorithmus spezifischer die von seinem Vorgänger: statt der Speicherung alle Daten über die Verbindung in jedem Knoten, die Knoten speichern nur jene Daten, die den virtuellen Neuronen.

Wissenschaftler haben auch jeden sendenden einem Neuron Ziel-Adressbuch. Während der übertragung von Daten aufgeteilt in Stücke, wobei jedes Fragment, das den Code enthält Postleitzahl, sendet Sie an die entsprechenden Knoten.

Schnelle und intelligente

Die Modifikation funktioniert.

Im Verlauf der Tests zeigte sich der neue Algorithmus viel besser als Ihre Vorgänger in Bezug auf Skalierbarkeit und Geschwindigkeit. Auf dem Supercomputer JUQUEEN in Deutschland-Algorithmus arbeitete auf 55% schneller als frühere Modelle auf zufälligen neuronalen Netzwerks, vor allem Dank seiner geradlinigen Schema der Datenübertragung.

Im Netz der Größe einer halben Milliarde Neuronen, Z. B. Simulation einer Sekunde biologischen Ereignisse dauerte etwa fünf Minuten Betriebszeit JUQUEEN auf einem neuen Algorithmus. Modell-Vorgänger nahmen sechs mal mehr Zeit.

Wie erwartet, mehrere Skalierbarkeit Tests haben gezeigt, dass der neue Algorithmus viel effizienter in der Verwaltung von großen Netzwerken, da die Bearbeitungszeiten verkürzen Zehntausenden Transfers von Daten dreimal.

«Jetzt ist der Schwerpunkt auf die Beschleunigung der Simulation mit den verschiedenen Formen der Netzwerk-Plastizität», — Schloss die Autoren. In diesem Sinne, endlich das digitale Gehirn des Menschen kann in Reichweite.

Der neue Algorithmus brachte uns zu einer vollständigen Simulation des Gehirns

Ilja Hel