Straks når Dr. Blake Richards hørt om dyb læring, indså han, at han står over for ikke kun en metode, der revolutionairy kunstig intelligens. Han indså, at kigge på noget grundlæggende fra den menneskelige hjerne. Det var i begyndelsen af 2000’erne, og Richards gennemført et kursus på Universitetet i Toronto sammen med Geoff Hinton. At Hinton, der var en af initiativtagerne til den algoritme, erobre verden, tilbød at læse indledningen til sin metode til undervisning inspireret af den menneskelige hjerne.

Det vigtige ord her er “inspireret af hjernen.” På trods af den overbevisning, at Richards, bet spillet mod ham. Den menneskelige hjerne, som det viste sig, har vigtige funktioner, som er programmerbar i algoritmer for dyb læring. På overfladen af disse algoritmer, der krænker de grundlæggende biologiske fakta er allerede blevet bevist af neurologer.

Men hvad nu hvis dyb læring og hjernen faktisk er forenelig?

Og nu, i en ny undersøgelse offentliggjort i eLife, Richards, der arbejder med DeepMind, foreslået en ny algoritme, baseret på den biologiske struktur af neuroner i neocortex. Cortex, hjernebarken, er hjemsted for det højeste kognitive funktioner som argumentation, forudsige og fleksibel tænkning.

Holdet sluttede sig til den kunstige neuroner i et lag net, og sæt det opgaven for den klassiske computer vision er at identificere håndskrevne cifre.

Den nye algoritme gjorde det godt. Men hvad der er mere vigtigt: han analyserede prøverne for uddannelse, som gør algoritmer for dyb læring, men blev bygget helt om den grundlæggende biologi af hjernen.

“Dyb læring er muligt i et biologisk struktur,” de forskere, der er indgået.

Fordi i det øjeblik denne model er en computer-version, Richards håber at videregive stafetten til eksperimenterende neuroforskere, som kan hjælpe dig med at kontrollere, om denne algoritme i en rigtig hjerne.

Hvis Ja, kan data overføres til computeren, forskere til at udvikle massivt parallelle og effektive algoritmer, der vil arbejde på vores biler. Dette er det første skridt i retning af en sammenlægning af de to felter i “god cirkel “dans” på opdagelse og innovation.

Søg efter en syndebuk

Selv om du har sikkert hørt, at kunstig intelligens har for nylig slået det bedste af det bedste go, du er usandsynligt at vide præcis, hvordan de algoritmer, der arbejder baseret på denne kunstige intelligens.

I en nøddeskal, dyb læring baseret på kunstige neurale netværk med en virtuel “neuroner”. Som højeste skyskraber, netværket er struktureret i et hierarki: low-level neuroner behandling input, for eksempel, der er vandrette eller lodrette streger, der udgør ciffer 4, og neuroner, der er behandlet med en høj-niveau abstrakte aspekter af nummer 4.

Til at træne netværket, skal du give hende eksempler på, hvad du leder efter. Signalet udbreder sig gennem netværket (op ad trappen af bygningen), og hver neuron er at forsøge at opfatte noget grundlæggende i arbejdet i Kvartetten.

Som børn lærer noget nyt, det første netværk ikke fairing meget godt. Hun giver alt, hvad der, efter hendes mening, ser ud som en nummer fire og komme i ånden af Picasso.

Men det er historien om læring: algoritmen sammenligner output med den ideelle input og beregner forskellen mellem dem (læs: fejl). Fejlen er “tilbage formeres” via nettet, undervisning hver neuron, de siger, er ikke, hvad du er på udkig efter, til at se bedre.

Efter millioner af eksempler og gentagelser, netværket begynder at fungere perfekt.

Fejl-signalet er ekstremt vigtigt for at lære. Uden en effektiv “back-propagation” netværk vil ikke vide, hvilke af dens neuroner er forkert. I jagten på en syndebuk kunstig intelligens forbedrer sig selv.

Hjernen også gør. Men hvordan? Vi har ingen idé.

Biologiske blindgyde

Det oplagte alternativ: en løsning med dyb uddannelse er ikke i orden.

Tilbage formering af fejl er en yderst vigtig funktion. Det kræver en vis infrastruktur til at fungere korrekt.

Første, hver neuron i det netværk, der skal modtage den fejl meddelelse. Men i hjernen neuronerne er forbundet med flere partnere på downstream (hvis det ikke er tilsluttet). For at vende sprede arbejdede i hjernen, neuroner på de første niveauer skal opfatte information fra de milliarder af forbindelser i faldende kanaler — og det er biologisk umuligt.

Og mens nogle dybe learning algoritmer tilpasse sig den lokale form af fejl back-propagation er hovedsageligt mellem neuroner — det kræver, at forbindelsen er frem og tilbage er symmetrisk. I synapser i hjernen, at dette ikke sker næsten aldrig.

Mere moderne algoritmer tilpasse sig en anden strategi, gennemførelse af en separat feedback sti, som hjælper neuroner finde fejl lokalt. Selv om det er mere realistisk biologisk hjerne ikke har et separat netværk, der er dedikeret til at søge efter syndebukke.

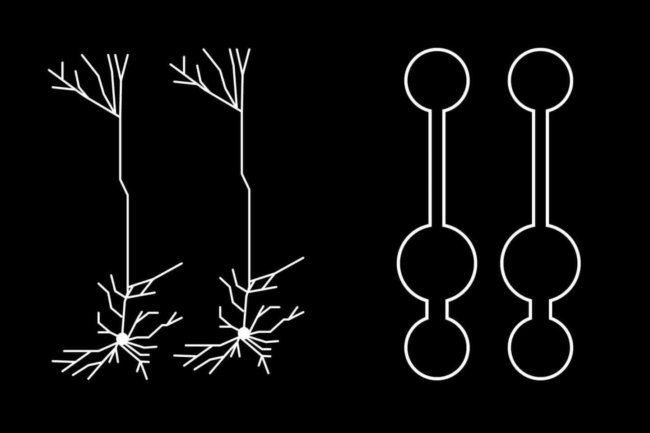

Men det har også neuroner med komplekse strukturer, i modsætning til den homogene “bolde”, som anvendes i øjeblikket i dyb læring.

Forgrenet netværk

Forskere med inspiration fra pyramideformede celler, der befolker cortex af den menneskelige hjerne.

“De fleste af disse neuroner er formet som træer, deres rødder går dybt ind i hjernen, og “grenene” kommer op til overfladen,” siger Richards. “Det er interessant, at rødderne får nogle input sæt og grene de andre.”

Mærkeligt nok, men den struktur af neuroner ofte er “præcis sådan” for effektivt at løse beregningsmæssige problemer. Tag, for eksempel, behandling af fornemmelser: bunden af en pyramide neuroner er placeret, hvor du har brug for, for at få touch input, og toppen er godt positioneret for transmission fejl gennem feedback.

Kan denne komplekse struktur til at være en evolutionær løsning til at bekæmpe den forkerte signal?

Forskere har skabt et flerlaget neurale netværk, der er baseret på de tidligere algoritmer. Men i stedet for homogene neuroner ligner de neuroner i det midterste lag klemt inde mellem input og output, der svarer til den virkelige ting. Læring håndskrevne cifre, den algoritme, der viste sig at være meget bedre end det indre netværk, på trods af fraværet af de klassiske fejl back-propagation. Celle-struktur, der var i stand til at identificere fejlen. Derefter, på det rigtige tidspunkt, det neuron, der kombinerer både en kilde til information for at finde de bedste løsninger.

Dette har en biologisk basis: neuroforskere har længe vidst, at input grene af neuron udføre lokale beregninger, der kan være integreret med signal tilbage-udledning fra produktionen grene. Men vi ved ikke, om hjernen fungerer i virkeligheden — derfor Richards pålagde neuroforskere at finde ud af.

Desuden er, dette netværk håndterer et problem, der ligner den traditionelle metode for dybt at lære at læse: bruger en flerlaget struktur til at udtrække gradvist mere abstrakte ideer om hvert nummer.

“Det er en funktion af dyb læring,” forklarer forfatterne.

Dyb læring hjernen

Uden tvivl, denne historie vil være mere drejninger, fordi dataloger laver flere og flere biologiske detaljer i algoritmer til AI. Richards og hans team overveje, om den intelligente funktion fra toppen og ned, når signaler fra højere niveau direkte indflydelse på, hvordan lavere niveauer reagere på input.

Feedback fra øverste niveauer, der ikke kun forbedrer signal-fejl; det kan også tilskynde neuroner til lav-niveau-behandling til arbejde “bedre” i real tid, siger Richards. Indtil netværket er overgået andre ikke-biologiske netværk dyb læring. Men det gør ikke noget.

“Dyb læring har haft en enorm indflydelse på AI, men til dato er dens indvirkning på den neuroscience var begrænset,” siger forfatterne af undersøgelsen. Nu neuroforskere vil have lejlighed til at gennemføre en pilot-test og lære, er den struktur af neuroner i bunden af den naturlige algoritme for dyb læring. Måske i de næste ti år vil begynde en gensidigt fordelagtig udveksling af data mellem neurologer og forskere i kunstig intelligens.

Gør vores hjerne dyb læring for at forstå verden?

Ilya Hel