Bild: Neurala

Bild: Neurala

Nicht überraschend, die neueste AI Fortschritt in der Körper-Kamera-Technologie kommt nicht näher auf zunehmende Rechenschaftspflicht der Polizei oder Offizier Transparenz. Als die öffentlichkeit drängen, Körper-Kameras hat nachgelassen, tech-Unternehmen sind jetzt dabei, Ihre eigene Berufung für Körper-Kameras für die Polizei, dass Sie kaufen: mit schärfer, intelligenter überwachung.

Am Montag, Motorola Solutions (die Rechtsnachfolgerin der aufgelösten Motorola, Inc.) angekündigt, eine neue Partnerschaft mit machine-learning-startup Neurala zu verwenden Objekterkennung AI in seiner Si500 Körper-Kameras. Neurala tech stellt erweiterte Erkennungsfunktionen, die Sie sagen, könnte helfen, Führungskräfte finden, vermisste Kinder oder vermutet, bei großen. Bürgerrechtler waren sofort besorgt, dies würde verwendet werden, für die Gesichtserkennung, eine lange gefürchtete Ereignis-Horizont für die persönliche Privatsphäre, wo die Offiziere konnten sofort feststellen, die Identitäten jemand Sie stoßen, zu jeder Zeit. Motorola und Neurala verweigert haben, die Technologie so genutzt werden, wenn Bedenken bleiben.

Die Neue Technologie Könnte Wiederum Die Polizei Body-Cams In Einen Alptraum Überwachungs-Tools

Immer und immer wieder, Polizisten zu Schießen, und manchmal töten, Zivilisten holding harmlos, Objekte, …

Lesen Sie mehr

Als co-Gründer Max Versace erklärte, Neurala Schulen seine software zu erkennen, Objekte, getragen von entweder den verdächtigen oder vermissten person, nicht Ihr Gesicht. Objekterkennung und Gesichtserkennung beide ernste Bedenken hinsichtlich der Privatsphäre, aber Sie sind nicht die gleichen.

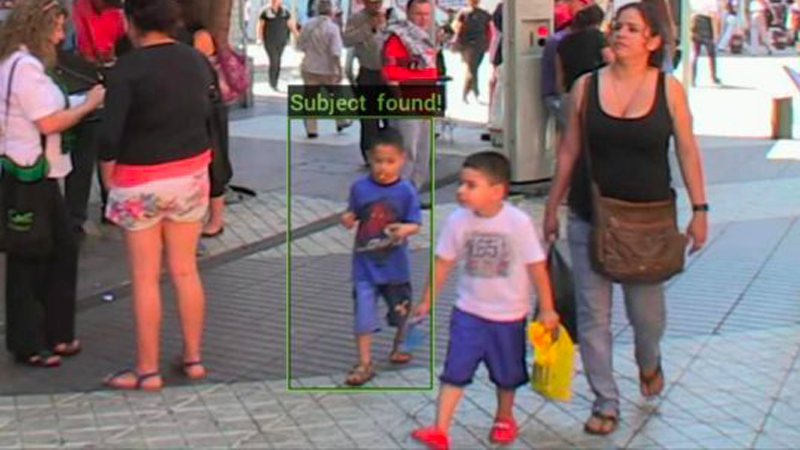

“Sie sind auf der Suche, für ein Kind in einem blauen shirt, roten Schuhen und weißen Hosen und schwarzen Haaren, [AI] lernen, [daß] und dann schieben Sie es auf alle Geräte,” Versace sagte Gizmodo. “Oder, wenn Sie bestimmte Bild von dieser person tragen diese Elemente, können Sie das tun.”

Als Versace vorstellt, ein Elternteil geben könnte Offiziere ein Foto von Ihrem Kind. Die KI ist dann ausgebildet, um zu erkennen der Objekte auf dem Foto und ein update geschoben, um alle CCTV-und Körper-Kameras Kennzeichnen diese Objekte in Echtzeit.

“Sie haben tausend Augen, die für ein bestimmtes Objekt,” Versace sagte.

Dies ist nicht das gleiche wie Gesichtserkennung, das ist eine drei-Schritt-Prozess. Ersten, AI hat zu Scannen und Messen Sie Ihre Gesichts-berechnen Ihre individuellen Messungen (die Breite der Augen, die Länge der Stirn, etc.) Ihr “faceprint.” Dass faceprint ist dann im Vergleich zu einer Datenbank von gespeicherten faceprints und “Anerkennung” tritt auf, wenn es eine übereinstimmung gibt.

Polizisten haben Zugriff auf Millionen von faceprints, weil Sie sind, stammen aus offiziellen Dokumenten, wie Führerschein, Fotos und Pässe. Neurala sagt, es wird nicht Scannen, Gesichter oder Stimmen Sie Ihnen zu Datenbanken und ferner, dass die meisten Kinder nicht in einem ID-Datenbank. Aber das bedeutet nicht, dass es nicht beunruhigend Aspekte über die Firma Vorschlag.

Als Versace erklärte, Neurala würde mit Objekten in der realen Zeit und mit Polizisten zu haben, die Kameras ständig auf und Scannen. Das ist wahrscheinlich zu geben, die Datenschutz-Experten der pause, als Sie sind sich einig, dass die Bullen sollten verpflichtet werden, (a) die Menschen zu informieren, wenn Sie aufgezeichnet werden, und (b) schalten Sie die Kameras, wenn Leute Fragen. Die meisten Menschen aufgezeichnet von always-on-body-Kameras werden nicht Verdacht einer straftat, aber Sie werden gefilmt und analysiert—ohne deren wissen oder Zustimmung.

Darüber hinaus werden die Objekte, die cops sind auf der Suche nach nicht unbedingt neutral. Vorstellen cops Trainings-software Kennzeichnen, wer trägt eine hijab oder Burka. Objekt-Erkennung zu automatisieren gezielte profiling, wodurch es einfacher für die cops zu Ueberwachen bestimmte Gemeinschaften. Versace ist sich bewusst, das Potenzial für die KI zu missbraucht, aber sagte, es ist nicht die Technologie, wir sollten vorsichtig sein.

“Menschen sind gefährlicher als AI,” Versace sagte. “Wir sollten uns Gedanken über uns und erst dann sorgen um AI.”