Sidste måned, menneskeheden tabte en vigtig kamp, med kunstig intelligens — så AlphaGo slå mesteren i th Ki Jae med score 3:0. AlphaGo er et program med kunstig intelligens udviklet af DeepMind, en del af moderselskabet Google Alfabet. Sidste år, hun besejrede en anden mester, Hvis Sedola, 4:1, men siden da har i høj grad vundet på point.

Ki Jae AlphaGo beskrevet som en “God game”.

Nu AlphaGo slutter med at spille spil, der giver spillerne mulighed for at, som før, til at kæmpe indbyrdes. Kunstig intelligens har opnået status af en “spiller fra en fjern fremtid”, som folk vil have til at vokse meget lang.

På din mark, få sæt, go

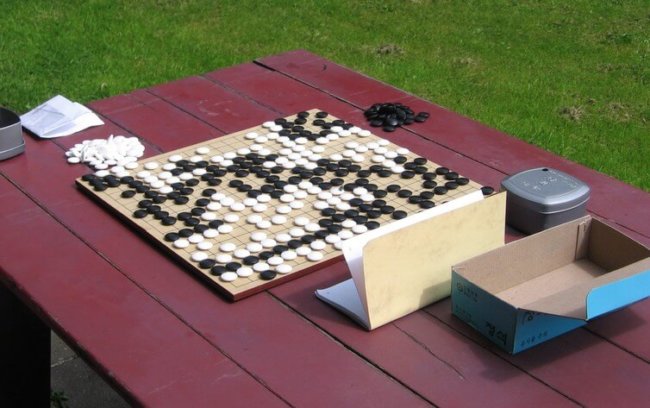

Go er et gammelt spil for to, hvor man spiller hvid, den anden sort. Opgave — for at fange dominans på Tavlen divideret med 19 horisontale og 19 lodrette linjer. Computere til at spille go er sværere end skak, fordi antallet af mulige bevæger sig i hver position meget mere. Dette gør den ved beregning af den potentielle bevæger sig på forhånd — er det muligt for computere i skak er meget vanskeligt.

DeepMind gennembrud var udviklingen af en Generel læring algoritme, som, i princippet, kunne være rettet til en mere socialt orienteret retning. DeepMind siger en gruppe forskere, der AlphaGo forsøger at løse komplekse problemer, såsom at finde nye kur for sygdomme, den radikale reduktion af energiforbruget eller udvikling af nye revolutionerende materialer.

“Hvis AI system viser, at du kan få ny viden og strategier på disse områder, er de gennembrud, der vil bare ubeskrivelig. Kan ikke vente med at se, hvad der vil ske næste,” siger en af forskerne på projektet.

I fremtiden, det står over for mange spændende muligheder, men problemet er der stadig.

Neurovidenskab og kunstig intelligens

AlphaGo kombinerer to stærke ideer om undervisning, der har udviklet sig over de sidste par årtier: dyb læring og styrkelse læring. Interessant nok kom begge fra det biologiske begreb i arbejdet og træning af hjernen i den proces for at få erfaring.

I den menneskelige hjerne sensorisk information er behandlet i en række lag. For eksempel, den visuelle oplysninger, der er første transformirovalsya i nethinden, så at de midbrain og passerer derefter gennem forskellige områder af hjernebarken.

Som et resultat, at der er et hierarki af predstaveni, hvor der ved første der er enkle og lokaliserede genstande, og derefter mere vanskelige og komplekse funktioner.

Det svarer til AI kaldes dyb læring: dybt, fordi det indeholder mange lag af behandling i de enkle neuronopathy computing-enheder.

Men for at overleve i denne verden, dyrene behøver ikke kun at anerkende, sensorisk information, men at handle i overensstemmelse med det. Generation af forskere og psykologer har undersøgt, hvordan dyr lærer at træffe foranstaltninger for at maksimere udbytte og opnå en belønning.

Alt dette har ført til, at matematiske teorier for styrkelse af læring, som nu kan gennemføres i AI-system. Den vigtigste af disse er den såkaldte TD-læring, som forbedrer den handling, ved at maksimere forventningen om de fremtidige priser.

Bedste bevægelser

Gennem en kombination af dyb læring og styrkelse læring i en serie af kunstige neurale netværk, AlphaGo først lærte at spille på det niveau, af en professionel go spiller på grundlag af 30 millioner bevæger sig i spil mellem mennesker.

Men så begyndte han at spille mod mig selv ved at bruge resultatet af hvert spil er at ubønhørligt med at finpudse deres egne beslutninger om, er det bedste træk i hver position på Tavlen. Det system af værdier af netværket lærte at forudsige det sandsynlige udfald med hensyn til hvilken som helst position, og systemet med forsigtighed, netværk lært at gøre den bedste beslutning i den enkelte situation.

Selv om AlphaGo ikke kunne prøve alle mulige positioner på Tavlen, det neurale netværk, der har lært de vigtigste idéer om strategier, der fungerer godt i enhver position. Det er disse utallige timer af uafhængige spil, har ført til forbedret AlphaGo i løbet af de sidste år.

Desværre, endnu ikke kendt måde at finde ud af, fra dit netværk, hvad slags centrale ideer. Vi kan studere spillet og håber at få noget ud af dem. Dette er et af problemerne med brugen af neurale algoritmer: at de ikke forklare deres beslutninger.

Vi forstår stadig meget lidt om, hvordan biologiske hjerner lære, og neurovidenskab, fortsætter med at levere nye kilder til inspiration for AI. Folk kan blive eksperter i spillet, guidede meget mindre erfaring end nødvendigt AlphaGo for at nå dette niveau, så der er plads til forbedring af algoritmer er der stadig.

Hertil kommer, at de fleste af magt AlphaGo baseret på en teknik, metode fejl tilbage formering, som hjælper hende til at rette fejl. Men forbindelsen mellem den og den uddannelse i en reel hjernen, er stadig uklart.

Hvad er det næste?

Spillet i go er en praktisk udvikling af platform til optimering af læring algoritmer. Men mange reelle problemer, hvor rodet og har mindre muligheder for at lære (fx, selvkørende biler).

Er der problemer, som vi kan anvende de eksisterende algoritmer?

Et eksempel kan være at optimere kontrollerede, industrielle forhold. Her er opgaven ofte er at udføre en kompliceret række opgaver for at tilfredsstille flere kriterier, og for at minimere omkostningerne.

Indtil da, indtil de betingelser, der kan være præcist modelleret, disse algoritmer vil lære og få erfaring, hurtigere og mere effektivt end mennesker. Du kan kun gentage de ord af virksomheden DeepMind: jeg vil gerne se, hvad der vil ske næste.

Spil afsluttet: AlphaGo vil blive engageret i at løse problemer fra den virkelige verden

Ilya Hel