Selvkjørende biler bruker mye tid på å se på sine omgivelser for å vite hvordan de skal forholde seg til den veien. Men autonome biler vil sannsynligvis bruke noen tid på å se på deg til å finne ut av hvordan de bør oppføre seg, også.

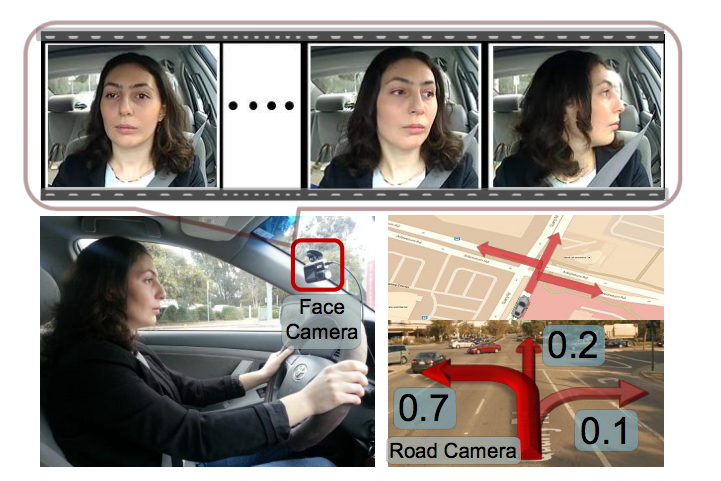

Et team av forskere fra Cornell University har vært å utvikle et nytt system som utdanner et kamera på driveren for å forstå hva de holder på med, å forutse deres handlinger fra tre sekunder ut. I første omgang systemet kan brukes til å supplere driver hjelpemidler som allerede vises på biler, men i fremtiden kan det bli brukt til å trene autonome biler ved å gi dem med en rik søm av ekstra data.

Teamet har bygget et Tilbakevendende Nevrale Nettverk som tar inn en rekke data kilder for å forutsi hva personen bak rattet kan gjøre. Det samler målinger av hastighet, GPS-posisjoner og hodet retning av driveren for å forsøke å tilordne en sannsynlighet på om ikke bilen vil endre lane i de neste par sekunder.

Etter å samle inn data fra 10 forskjellige drivere som dekket 1000 miles på motorveien og by over to måneder, team forklart opptakene for å trene sine nevrale nettverk. Med 700 hendelser—300 lane endringer, 130 svinger, og nesten 300 tilfeldig valgt tilfeller av kjøring rett tygges gjennom, det ble deretter sluppet løs på live data til å gjette hva som kan skje. Laget skriver i en artikkel publisert på arXiv at programvaren kan forutse manøvrer 3,5 sekunder før de oppstår i realtime.”

Det er ganske imponerende, men så, lane endringer på motorveier er sannsynligvis en av de enkleste å forutsi. Det vil være interessant å se hva laget kan faktisk gjøre med data for nåværende og kommende biler, og hvordan de kan justere den til å forutsi mer subtile handlinger i travle bygater, også.

Sponset

[arXiv via arXiv Blogg]

Bilde av HomeArt/Shutterstock