Den Information Technology & Innovation Foundation har släppt sin nominerade för sin årliga Luddite Awards. Erkänner “den värsta av årets värsta innovation mördare,” årets gröda som innehåller allt från begränsningar för samåkning till förbud mot automatisk registreringsskylt läsare. Men genom att hänvisa till “AI-alarmists” som neo-Luddites, ITIF har gått för långt.

Den ITIF är en icke-vinstdrivande tankesmedja baserad i Washington, D.C. som fokuserar på offentlig politik att främja tekniska innovationer. Varje år ITIF sätter ihop en lista över vad man anser är årets sämsta innovation mördare. Döpt för att hedra Ned Lud, en Engelsman som ledde en rörelse i början av 19-talet för att förstöra mekaniska vävstolar, erkänner belöna de mest flagranta exempel på en organisation, myndighet eller enskilda förhindra utvecklingen av teknisk innovation.

“Neo-Luddites inte längre utöva sledgehammers, men de använder något mycket mer kraftfullt: dåliga idéer”, skriver Robert D. Atkinson, ITIF s grundare och vd. “För att de arbetar för att övertyga beslutsfattare och allmänheten om att innovation är orsaken, inte lösningen på några av våra största sociala och ekonomiska utmaningar, och därför något som ska motarbetas.” Han säger “de söker en värld som är i stort sett fria från risk, innovation, eller okontrollerad förändring.”

I ingen speciell ordning, här är årets nominerade:

- Alarmists tout en artificiell intelligens apocalypse

- Förespråkar söka ett förbud mot “killer robotar”

- Medlemsstaterna begränsa automatisk registreringsskylt läsare

- Europa, Kina och andra väljer taxi förare över samåkning passagerare

- Pappersindustrin motsätter sig e-märkning

- Kaliforniens guvernör veton RFID i körkort

- Wyoming outlaws medborgare vetenskap

- Federal Communications Commission gränser bredband innovation

- Centrum för Livsmedelssäkerhet slagsmål genetiskt modifierade livsmedel

- Ohio och andra förbud mot rött ljus kameror

Den ITIF utfärdat en kompletterande rapport som förklarar årets skörd av kandidaterna, så om du vill ha en detaljerad redogörelse för varje punkt ovan föreslår jag att du kolla upp det. Institutet har också lanserat en online-enkät ber allmänheten att rösta fram sin favorit inlägg. “Vinnaren” meddelas någon gång i januari.

Sponsrade

Om man tittar på listan över de nominerade, de senaste sju objekt som saknar mening, men jag kan liksom förstå varför RFID-taggar i förarens licenser kan ses som en integritet och säkerhet oro. Men som för de två första, och noteringen av “AI-alarmists” som neo-Luddites, ja, nu som fått mig lite oroad.

Att förhindra att en AI-Apokalypsen

Den ITIF: s klagomål om alarmists försöker pracka på en artificiell intelligens apocalypse har att göra med ett öppet brev skapad av Framtiden för Life Institute tidigare i år. Bill Gates, Stephen Hawking, Elon Musk, och andra offentliga personer undertecknat en skrivelse, som varnat för risken för AI att så småningom fly från vår kontroll och framstår som ett apokalyptiskt hot. Samtidigt, emellertid, undertecknarna drivit på för ansvarig AI tillsyn som ett sätt att mildra risker och se till att den “samhälleliga nytta” av tekniken.

(Bild: Avengers: Age of Ultron (2015))

Men till ITIF, detta är bara ytterligare ett försök till stall viktig innovation. Vad är mer, institutet hävdar att AI är tydligen inget att oroa sig för eftersom det är för långt bort i framtiden.

“Om sådana system någonsin kommer att utveckla full autonomi är en omtvistad fråga, men vad som inte bör diskuteras är att detta är möjligt i framtiden är en lång, lång väg (mer som ett århundrade än ett decennium), och det är därför för tidigt att oroa om “Skynet” bli medveten”, säger Atkinson, “Verkligen, en fortsatt negativ kampanj mot artificiell intelligens potentiellt skulle kunna torka upp finansiering för AI-forskning, andra än pengar för hur man styr, snarare än att göra det möjligt AI.”

Atkinson hävdar dessa sci-fi domedagsscenarier är att göra det svårare för allmänheten, beslutsfattare och forskare för att stödja mer finansiering för AI-forskning.

Det är ganska talande, ITIF inte nämna den nyligen meddelade icke-vinstdrivande OpenAI research company co-grundades av Elon Musk. $1 miljard initiativ har förbundit sig att “främja digital intelligens på ett sätt som är mest sannolikt att gynna mänskligheten som helhet.” Projektet går med andra liknande initiativ som lanserades av framstående företag såsom Google, Apple och IBM. Flera liknande akademiska initiativ finns också, bland annat Future of Humanity Institute vid Oxford och den nyligen lanserade Centrum för Studiet av Existentiell Risk vid Universitetet i Cambridge.

Dessa initiativ—för att inte tala om de miljarder som spenderas på AI-forskning och utveckling runt om i världen—visa att Atkinson farhågor är överdrivna. Vad är mer, och i den anda av FLI öppna brev, det är absolut inte för tidigt att tänka på de potentiella riskerna. Mänsklighetens överlevnad kan stå på spel. Tillkomsten av en stark artificiell intelligens—och framför allt artificiell superintelligens—kan visa sig vara den mest omvälvande teknisk innovation i historien av vår art, så det är viktigt att vi gör det rätt. Klart, vi pratar inte om Ned Lud ‘ s steam-powered vävstolar.

Död åt de Döda Maskiner

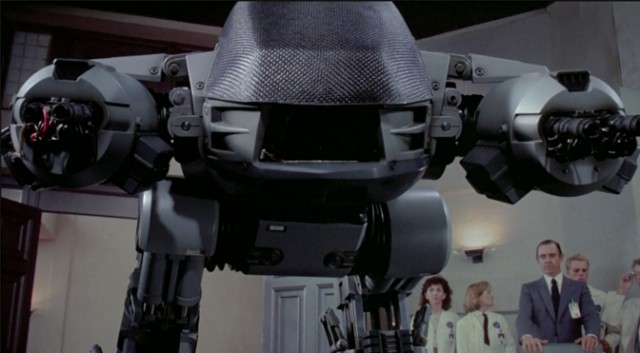

Och då är det frågan om autonoma vapen. En del av ITIF klagomål har att göra med ett annat öppet brev på uppdrag av FLI, en kallelse för ett totalförbud mot autonoma döda maskiner. Undertecknarna ingår Hawking, Mysk, Steve Wozniak, Noam Chomsky, MIT fysikern Max Tegmark, och Daniel C. Dennett.

(Bild: Robocop (1987))

Den ITIF också haft problem med ett Fn-möte tidigare i år att överväga ett formellt förbud eller andra begränsningar på killer AI, och en särskild rapport skriven av Human Rights Watch och Harvard Law School, som propagerade för ett moratorium för sådana vapen.

Atkinson säger argument mot att döda maskiner “har utsikt över det faktum att den militära tydligt kommer att gynnas, eftersom att ersätta robotar för soldater på slagfältet, kommer att öka en militär kapacitet och samtidigt minskar risken för att dess personal”, och tillade att det är “möjligt att autonoma vapen kan programmeras för att delta endast känd fiendens soldater, som även kan leda till en minskning i civila offer.”

Atkinson avslutar med att säga att “kampen för att förbjuda autonoma vapen, mycket som kommer att slåss om artificiell intelligens, arbetar mot den samhälleliga mål att skapa innovationer som kommer att förbättra människors liv.”

Den ITIF har rätt i att påpeka att automatiska vapen har potential att minska dödsfallen på killing field, men tanken att dessa system kommer att vara i stånd att skilja mellan stridande och civila är svårt att svälja. Vad är mer, som med all militär innovation, det måste antas att fienden kommer så småningom att utveckla sin egen version. Slutligen, en AI kapprustning kunde leda till superintelligenta system som kamp för dominans utanför den mänskliga förståelse och kontroll. Skulle detta hända, vi har inget annat val än att luta sig tillbaka och hoppas att vi inte får förstörs i processen.

Ett grundläggande problem med den ITIF är dess orubbliga tro på mänskliga samhällen att anpassa sig till sin teknik. Hittills, vi har till stor del lyckats göra så. Vi har även lyckats överleva — åtminstone för tillfället — utveckling av den första apokalyptiska skala vapen i form av en atombomb. Tyvärr, andra faror som väntar oss i framtiden, så att vi på bästa sätt vara redo.

På samma gång, vi förtjänar rätt att varna för dessa potentiella risker utan rädsla för att bli stämplad som Luddite.

[ ITIF JAG, II, III ]

E-post författaren på george@gizmodo.com och följ honom på @dvorsky. Översta bilden: Ex Machina (2015)