De Oplysninger, Teknologi & Innovation Foundation har udgivet sin nominerede til sin årlige Luddite Awards. Erkendelse “den værste af årets værste innovation mordere,” dette års afgrøde, der omfatter alt fra restriktioner på samkørsel til forbud mod automatiske nummerplade-læsere. Men ved at henvise til “AI alarmists” som neo-Luddites, ITIF er gået for langt.

Den ITIF er en not-for-profit tænketank, der er baseret ud af Washington, DC, som fokuserer på offentlige politikker, der kan fremme den teknologiske innovation. Hvert år, den ITIF sammensætter en liste over, hvad det mener er årets værste innovation mordere. Opkaldt til ære for Ned lud, mesjek, en Englænder, der førte en bevægelse i begyndelsen af det 19 at ødelægge mekaniske væve, prisen anerkender de mest grelle eksempler på en organisation, regeringen eller enkelte forhindring af fremskridt i teknologisk innovation.

“Neo-Luddites ikke længere svinge sledgehammers, men de svinge noget, der er langt mere kraftfuld: dårlige ideer,” skriver Robert D. Atkinson, ITIF ‘ s grundlægger og formand. “For de arbejder for at overbevise de politiske beslutningstagere og offentligheden, at innovation er årsagen, ikke er løsningen på nogle af vores største sociale og økonomiske udfordringer, og derfor noget at blive modarbejdet.” Han siger, “de søger i en verden, der er stort set fri for risiko, innovation, eller ukontrolleret forandring.”

I nogen bestemt rækkefølge, og her er dette års nominerede:

- Alarmists tout en kunstig intelligens-apocalypse

- Fortalere søge et forbud mod “killer robotter”

- Medlemsstaterne begrænse automatisk nummerplade læsere

- Europa, Kina, og andre vælger taxa chauffører over bil-deling af passagerer

- Papirindustrien er imod e-mærkning

- Californiens guvernør vetoer RFID i kørekort

- Wyoming outlaws borger videnskab

- Federal Communications Commission grænser bredbånd innovation

- Center for Food Safety kampe genetisk modificerede fødevarer

- Ohio og andre forbud rødt lys kameraer

Den ITIF udstedt en ledsagende rapport, der forklarer, er dette års afgrøde af kandidater, så hvis du ønsker en detaljeret forklaring til hvert punkt ovenfor vil jeg foreslå dig at tjekke det ud. Instituttet også lanceret en online-meningsmåling spørge befolkningen til at stemme på deres favorit indlæg. De “vinder”, vil blive annonceret engang i januar.

Sponsoreret

Ser man på listen over nominerede, de sidste syv elementer, der giver mening, selvom jeg kan forstå, hvorfor RFID-tags i kørekort kan ses som en beskyttelse af privatlivets fred og sikkerhed bekymring. Men som for de to første, og opførelsen af “AI alarmists” som neo-Luddites, nå, nu har fået mig en smule urolig.

Forhindrer, at en AI-Apocalypse

Den ITIF ‘ s klage over alarmists udråber en kunstig intelligens apocalypse har at gøre med et åbent brev, der er skabt af den Fremtidige Liv Institute tidligere i år. Bill Gates, Stephen Hawking, Elon Musk, og andre offentlige personer har underskrevet brev, der advarede om risikoen for AI til sidst flygte fra vores kontrol, og fremstå som en apokalyptisk trussel. På samme tid, men underskriverne skubbet for ansvarlig AI tilsyn, som er en måde at mindske risici og sikre, at den “nytte for samfundet” af teknologien.

(Billede: Avengers: Alder Ultron (2015))

Men til ITIF, dette er blot endnu et forsøg på at bremse vigtig nyskabelse. Hvad mere er, instituttet hævder, at AI er tilsyneladende ikke noget at bekymre sig om, fordi det er for langt ude i fremtiden.

“Uanset om sådanne systemer nogensinde vil udvikle fuld selvstændighed er et omdiskuteret spørgsmål, men hvad der skal ikke diskuteres er, at denne mulige fremtid er en lang, lang vej fra (mere som en århundrede end et årti), og det er derfor for tidligt at bekymre sig om ‘Skynet’ at blive selv-bevidst,” siger Atkinson, “Ja, fortsatte den negative kampagne mod kunstig intelligens, der potentielt kunne tørre op midler for AI forskning, andet end penge for sådan at styre, snarere end at sætte AI.”

Atkinson hævder disse sci-fi dommedagsscenarier er at gøre det sværere for den offentlige, politiske beslutningstagere og forskere til at støtte flere midler til AI forskning.

Rammende, ITIF undladt at nævne den nyligt annoncerede ikke-for-profit OpenAI forskning selskab, medstifter af Elon Musk. Den $1 mia initiativ er forpligtet til “at fremme digital intelligens på en måde, der er mest tilbøjelige til at gavne menneskeheden som helhed.” Projektet slutter sig til andre lignende initiativer, der er iværksat af fremtrædende virksomheder som Google, Apple og IBM. Flere lignende faglige initiativer findes så godt, herunder de Fremtidige of Humanity Institute ved Oxford og den nyligt lancerede Center for Studiet af Eksistentiel Risiko ved University of Cambridge.

Disse initiativer—for ikke at nævne de mange milliarder, der bliver brugt på AI forskning og udvikling rundt om i verden—viser, at Atkinson ‘ s bekymringer er overvurderet. Hvad mere er, og i den ånd, den FLI åbent brev, er det absolut ikke for tidligt at tænke på de potentielle risici. Overlevelse af menneskeheden kunne være på spil. Fremkomsten af stærk kunstig intelligens—og især kunstige superintelligens—kan vise sig at være den mest forstyrrende teknologisk innovation i historien for vores arter, så det er afgørende, at vi gør det rigtige. Det er klart, vi taler ikke om Ned lud, mesjek ‘ s damp-drevne væve.

Døden til dræbermaskiner

Og så er der spørgsmålet om autonome våben. En del af ITIF ‘ s klage har at gøre med endnu et åbent brev, som er bestilt af FLI, der opfordrede til et forbud mod autonome dræbermaskiner. Underskriverne i prisen Hawking, Moskus, Steve Wozniak, Noam Chomsky, MIT fysiker Max Tegmark, og Daniel C. Dennett.

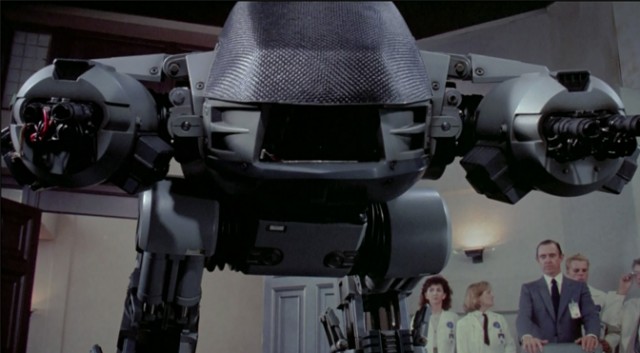

(Billede: Robocop (1987))

Den ITIF havde også et problem med et Fn-møde, der blev afholdt tidligere i år til at overveje et formelt forbud eller andre begrænsninger på killer AI, og en særlig rapport, som er udarbejdet af Human Rights Watch og Harvard Law School, der opfordrede til et moratorium for sådanne våben.

Atkinson siger argumenter mod dræbermaskiner “overser det faktum, at militæret klart vil være til gavn, fordi erstatte robotter til soldater på slagmarken vil stige militære kapaciteter, mens der i væsentlig grad mindske risikoen for, at dens personale,” tilføjer, at det er “muligt, at autonome våben kunne blive programmeret til at engagere sig kun kendt fjendtlige kombattanter, som kan endda føre til en reduktion i dødsfald blandt civile.”

Atkinson slutter af med at sige, at “slaget om at forbyde autonome våben, ligesom kampen om kunstig intelligens, virker mod den samfundsmæssige mål om at skabe innovationer, der vil forbedre den menneskelige tilværelse.”

Den ITIF er ret i at påpege, at robot-våben har potentiale til at nedbringe antallet af dræbte felt, men tanken om, at disse systemer vil være i stand til at diskriminere mellem kombattanter og civile er hård at sluge. Hvad mere er, som med enhver militær innovation, at det må antages, at fjenden i sidste ende vil udvikle sin egen version. Endelig, en AI våbenkapløb kan føre til superintelligent systemer, der kæmper for dominans uden for menneskets forståelse og kontrol. Skulle dette ske, har vi intet andet valg end at læne sig tilbage og håbe, vi ikke får ødelagt i processen.

Et grundlæggende problem med ITIF er sin urokkelige tro på den menneskelige samfund til at tilpasse sig sine teknologier. Til dato, vi har stort set lykkedes at gøre det. Vi har endda formået at overleve — i hvert fald for nu — udvikling af den første apokalyptisk-skala våben i form af en atombombe. Desværre, andre farer, der venter os i fremtiden, så vi bedst være klar.

På samme tid, vi fortjener retten til at advare om potentielle farer uden frygt for at blive stemplet som Luddite.

[ ITIF JEG, II, III ]

E-mail forfatteren på george@gizmodo.com og følge ham på @dvorsky. Øverste billede: Ex Machina (2015)