Mer än 50 ledande experter inom området för utveckling av artificiell intelligens meddelat sin avsikt att bojkotta Korean Institute of advanced technology (KAIST) är en prestigefylld och ledande utbildning och forskning Universitetet i Sydkorea för upprättandet av ett laboratorium för utveckling av vapen med hjälp av artificiell intelligens. Detta sade de i ett öppet brev.

Indignation av experter från fältet AI kallades och KAIST har tecknat ett avtal med företaget Hanwha vapen System, som enligt olika källor, engagerade i utvecklingen av kraftfulla vapen, inklusive, bland annat, har klusterbomber, som är förbjudet enligt FN-Konventionen om klusterammunition (Sydkorea detta Fördrag).

“Samtidigt som Fn: s diskussioner om hur innehålla hot mot internationell säkerhet som Autonoma vapen, det är ett beklagligt faktum att ett så prestigefyllt Universitet som KAIST, letar efter sätt att påskynda kapprustningen genom utveckling av sådana nya typer av vapen”, skriver experter på AI i öppet brev.

“Vi därför att offentligt deklarera att vi kommer att bojkotta alla typer av samarbete med alla avdelningar på KAIST så länge som Ordförande för KAIST inte ge en garanti på att centrum kommer inte att engagera sig i utvecklingen av Autonoma vapen, vars funktion är möjligt utan mänsklig intervention”.

KAIST har till sitt förfogande några av de bästa i världen av robotar och science laboratory: det bedrivs forskning och utveckling av olika avancerade tekniker, allt från flytande batterier och medicinsk utrustning.

Chefen för KAIST Shin sung-Chul sa att han var ledsen över beslutet att bojkotta, och tillade att Institutet inte kommer att skapa killer robotar.

“Som en akademisk institution, vi uppskattar de mänskliga rättigheterna och etiska normer. KAIST kommer inte att bedriva forskning om verksamhet som strider mot principerna om mänsklig värdighet, inklusive att utveckla Autonoma vapen som inte kräver mänsklig kontroll”, säger Shin sung Chol i sitt officiella uttalande om bojkott.

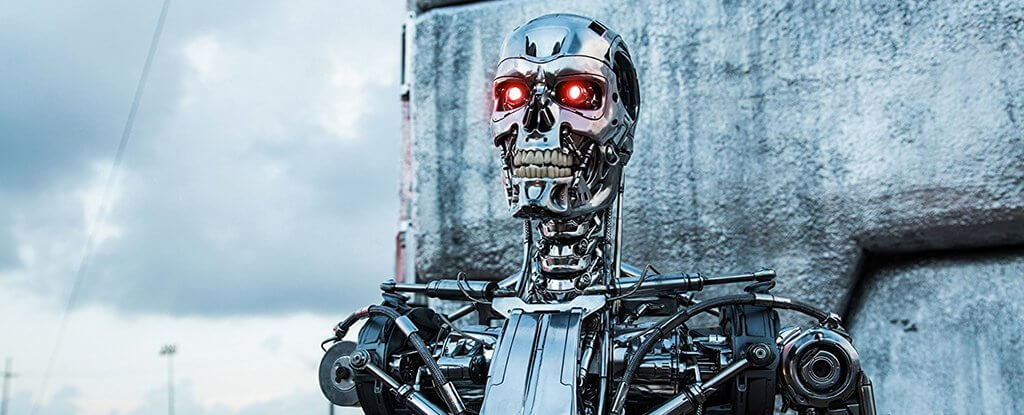

Med tanke på den snabba utvecklingen av hårdvara och mjukvara, många experter är oroliga för att förr eller senare kommer vi att skapa något som inte kommer att kunna kontrollera. Elon Musk, Steve Wozniak, nyligen avlidne Stephen Hawking och många andra mycket framstående personer inom IT-teknik på den tiden, uppmanade regeringar och FN för att införa restriktioner för utveckling av vapensystem, AI.

Enligt många, om vi kommer till missiler och bomber, vars funktion kommer att vara möjligt oberoende av mänsklig kontroll, kan konsekvenserna bli förödande, särskilt om en sådan teknik föll i fel händer.

“Skapa Självständiga vapen kommer att leda till den tredje revolutionen i militära Frågor. Den här tekniken kommer att möjliggöra en snabbare, förödande och storskaliga militära konflikter”, — författarna i öppet brev.

“Dessa tekniker kan bli ett vapen av terror. Diktatorer och terrorister kan använda dem mot den oskyldiga civilbefolkningen, och att ignorera alla etiska överväganden. Detta är en riktig Pandoras ask, som ligger nära, om det är öppet, skulle vara nästan omöjligt.”

FN: s medlemmar kommer att hålla nästa veckas möte, som kommer att diskutera frågor med anknytning till förbudet mot dödliga Autonoma vapen som kan döda utan mänsklig inblandning. Förresten, kommer det redan vara långt ifrån första sådant möte, men diskussionen har ännu inte kommit till någon överenskommelse. Ett av de problem som står i vägen för att göra några särskilda beslut, är att vissa länder inte bara minnet av utvecklingen av denna teknik eftersom de kan öka sin militära potential. Bli en stötesten och privata företag som aktivt motstå kontroll av regeringar för att utveckla sina egna modeller av system av artificiell intelligens.

Det verkar som om många håller med om det faktum att killer robotar är dåliga. Men, för att ta några särskilda beslut om vad man ska göra med deras utveckling, det fungerar ändå inte. Det är möjligt att utvecklingen av nya vapensystem, som planerar att ta KAIST, kommer att göra mer av parterna att delta i den nödvändiga diskussionen av problemet.

Många forskare uppmanar till skapandet av rekommendation om riktlinjer för utveckling och spridning av AI-system. Men en hög sannolikhet att även i närvaro av dessa skulle vara mycket svårt att säkerställa att varje part följa dem.

“Vi är besatta med kapprustningen, som ingen vill ha. KAIST åtgärder som kommer att påskynda den kapprustning. Vi kan inte tolerera det. Jag hoppas att denna bojkott kommer att öka betydelsen av behovet av att diskutera frågan på FN: s på måndag”, kommenterade Professor på artificiell intelligens av Australian University of New South Wales Toby Walsh, även undertecknat brev.

“Detta är en tydlig vädjan till samhället är inblandade i utvecklingen av tekniker för artificiell intelligens och robotik — inte för att stödja utvecklingen av Autonoma vapen. Alla andra institutioner som vill öppna liknande labs bör tänka två gånger.”

En sydkoreansk Institutet har aviserat en bojkott för utveckling av försvarsmateriel på grundval av AI

Nikolai Khizhnyak