Die künstliche Intelligenz. Wie viel wird darüber gesagt, aber wir selbst und sprechen noch gar nicht begonnen haben. Fast alles, was Sie hören über den Fortschritt der künstlichen Intelligenz basiert auf den Durchbruch, der dreißig Jahre. Speichern das Tempo des Fortschritts umgehen erfordert ernsthafte Einschränkungen schwere Einschränkungen. Weiter in der ersten Person — James Somers.

Ich stehe dort, wo bald das Zentrum der Welt, oder einfach nur in einem großen Raum im siebten Stock glänzende Türme in der Innenstadt von Toronto — wie man es betrachtet. Mich begleitet Jordan Jacobs, Mitbegründer des Instituts Vektor, der im Herbst dieses Jahres öffnet seine Türen und verspricht die Globale Epizentrum der künstlichen Intelligenz.

Wir in Toronto, weil Geoffrey Hinton in Toronto. Und Geoffrey Hinton — Vater «Deep learning», der Technik, der zugrunde liegenden Hype zum Thema KI. «In 30 Jahren werden wir zurückblicken und sagen, dass Jeff — Einstein für die KI, Deep learning, allem, was wir nennen künstlicher Intelligenz», sagt Jacobs. Von allen KI-Forscher Hinton zitieren häufiger als drei Fuß hinter ihm zusammen. Seine Studenten und Doktoranden arbeiten gehen im Labor KI in Apple, Facebook und OpenAI; Hinton selbst — ein führender Wissenschaftler im Team von Google Brain AI. Praktisch jede Errungenschaft auf dem Gebiet der KI in den letzten zehn Jahren — in der übersetzung, Spracherkennung, Erkennung von Bildern und spielen — so oder anders für die Arbeit Hinton.

Institut Vektor, dieses Denkmal Besteigung Ideen Hinton, ist ein Forschungszentrum, in dem Unternehmen aus allen US-und Kanada — wie Google, Uber und NVIDIA — Sponsor die Anstrengungen zur Kommerzialisierung von Technologien der KI. Geld fließen schneller als Jacobs schafft es, zu Fragen; zwei seiner Co-Gründer Befragten Unternehmen in der Region Toronto, und die Nachfrage nach Experten im Bereich der KI war 10-mal höher als Kanada liefert jedes Jahr. Institut Vektor in gewissem Sinne непаханая Neuland für versuche, die Welt um sich herum zu mobilisieren Deep learning: um in diese Technik investieren, Sie zu unterrichten, trainieren und anwenden. Rechenzentren gebaut, Wolkenkratzer Start-UPS gefüllt, in den Bereich fließen eine ganze Generation von Studenten.

Wenn man auf dem Boden «Vektor» hat das Gefühl, dass Sie am Anfang etwas. Aber die Tiefe der Ausbildung, im Kern sehr alt. Bahnbrechende Artikel Hinton, das er gemeinsam mit David Румельхартом und Ronald Williams, veröffentlicht im Jahr 1986. In der Arbeit beschreibt detailliert die Methode der inversen Verteilung des Fehlers (backpropagation), «бэкпроп», wenn es kurz ist. Бэкпроп, laut John Cohen, ist «alles, worauf beruht die Tiefe Ausbildung — in der Regel alle».

Wenn man an der Wurzel, heute KI ist die Tiefe Ausbildung und tiefgreifende Ausbildung ist бэкпроп. Und es ist erstaunlich, wenn man bedenkt, dass бэкпропу mehr als 30 Jahren. Zu verstehen, wie es passiert ist, gerade brauchen: die Technik konnte so lange warten und dann eine Explosion verursachen? Denn sobald Sie lernen die Geschichte бэкпропа, werden Sie verstehen, was jetzt Los ist mit der KI, und auch das, was wir können und stehen nicht am Anfang der Revolution. Vielleicht werden wir am Ende solche.

Ein Spaziergang vom Institut Vektors im Büro Hinton in Google, wo er verbringt die meiste seiner Zeit (er ist jetzt emeritierter Professor der Universität Toronto) ist eine Art von Live-Werbung für die Stadt, zumindest im Sommer. Es wird klar, warum Hinton, der ursprünglich aus Großbritannien, zog hier in den 1980er Jahren nach der Arbeit an der Carnegie Mellon University in Pittsburgh.

Kann es sein, dass wir nicht am Anfang der Revolution

Toronto ist die viertgrößte Stadt Nordamerikas (nach Mexiko-Stadt, New York und Los Angeles) und sicherlich vielfältiger: mehr als die Hälfte der Bevölkerung wurde außerhalb Kanadas geboren. Und es zeigt, wenn Sie gehen durch die Stadt. Die Menge multinational. Es gibt Kostenlose Gesundheitsversorgung und gute Schulen, die Leute freundlich, Richtlinien in Bezug auf die linke und stabil; alles zieht die Menschen wie Hinton, der sagt, dass ist aus der USA wegen «Ирангейта» (Iran-Contra — ein großer politischer Skandal in den USA in der zweiten Hälfte der 1980er Jahre; dann wurde bekannt, dass einzelne Mitglieder der US-Administration organisierten geheime Waffenlieferungen in den Iran, damit gegen die Waffen-Embargo gegen das Land). Mit diesem beginnt unser Gespräch vor dem Mittagessen.

«Viele glaubten, dass die USA ganz dringen in Nicaragua», sagt er. «Sie irgendwie dachten, dass Nicaragua gehört zu den Vereinigten Staaten». Er erzählt, dass vor kurzem feststellte, ein großer Durchbruch im Projekt: «Mit mir begann ein sehr guter Junior-Ingenieur», eine Frau namens Sarah Sabur. Sabur sind Iranerin, und Ihr das Visum verweigert wurde für die Arbeit in den USA. Büro von Google in Toronto gezogen.

Хинтону 69 Jahren. Er hat eine scharfe, Thin Englisches Gesicht mit dem dünnen Mund, großen Ohren und der stolzen Nase. Er wurde in Wimbledon und im Gespräch erinnert der Erzähler ein Kinderbuch über die Wissenschaft: neugierig, verlockenden, versucht alles zu erklären. Er ist lustig und ein wenig spielt mit dem Publikum. Ihm weh zu sitzen wegen der Probleme mit dem Rücken, so dass er nicht Fliegen kann, und auf der Aufnahme beim Zahnarzt fällt auf die Vorrichtung, ähnlich einem Surfbrett.

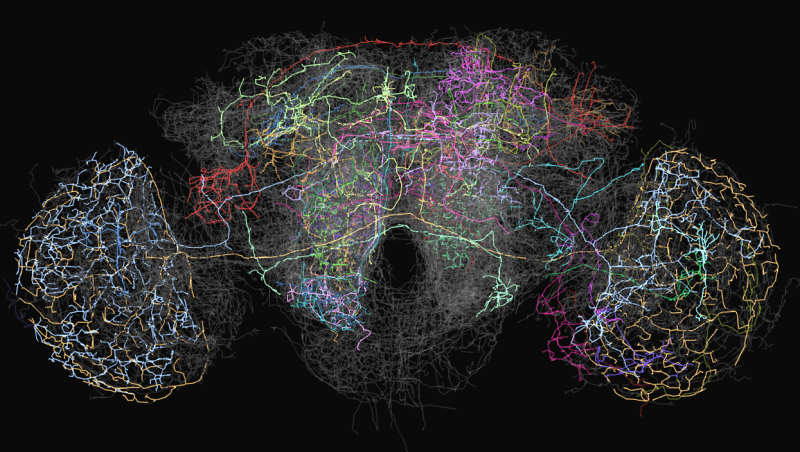

In den 1980er Hinton war, wie heute, ein Experte für neuronaler Netzwerke, eine wesentlich vereinfachte Modelle Netzwerk von Neuronen und Synapsen unseres Gehirns. Allerdings war damals fest beschlossen, dass neuronale Netze — eine Sackgasse in der KI-Forschung. Obwohl die erste neuronales Netz «Перцептрон» wurde in den 1960er Jahren und er galt als der erste Schritt in Richtung maschinelle Intelligenz der menschlichen Ebene, im Jahr 1969 Marvin Мински und Seymour Паперт mathematisch bewiesen, dass solche Netzwerke können nur die einfachsten Funktionen. Bei dieser Netzwerke gab es nur zwei Schichten von Neuronen: eine Schicht Eingabe-Schicht und output. Netzwerk mit einer großen Anzahl von Schichten zwischen den Neuronen der Eingabe-und Ausgabe konnten, in der Theorie, lösen eine Vielzahl von Problemen, aber niemand wusste, wie Sie zu erziehen, so dass Sie in der Praxis nutzlos. Wegen «Перцептронов» von der Idee neuronaler Netze weigerten sich fast alle mit wenigen Ausnahmen, darunter Hinton.

Durchbruch Hinton 1986 Bestand darin, zu zeigen, dass die Methode der inversen Verteilung Fehler kann trainieren Tiefe neuronale Netz mit der Anzahl der Schichten mehr als zwei oder drei. Aber es dauerte noch 26 Jahre, bevor die erhöhte Rechenleistung. In einem Artikel 2012 Hinton und seine beiden Schüler aus Toronto zeigten, dass Tiefe neuronale Netze, trainiert mit der Anwendung бэкпропа, zogen die besten bilderkennungssystem. «Deep learning» auf dem Vormarsch. Die Welt über Nacht beschlossen, dass am morgen die KI macht ergreift. Für Hinton ist der lang erwartete Sieg war.

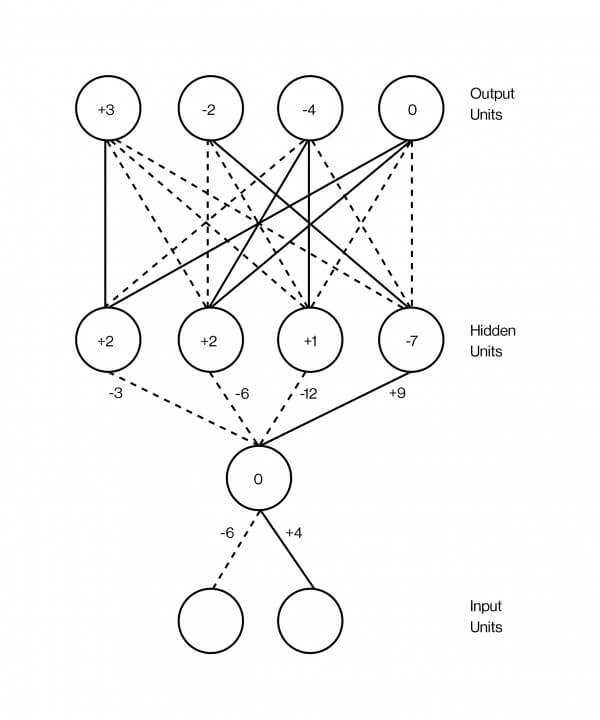

Feld Verzerrung Realität

Neuronales Netz wird gemeinhin als Sandwich, dessen Schichten überlagert. Diese Schichten enthalten die künstlichen Neuronen, die in Ihrem Wesen sind die kleinen Computing-Einheiten, die aufgeregt sind — wie erregt echte Neuron — und übertragen diese Begeisterung an andere Neuronen, die miteinander verbunden sind. Erregung des Neurons dargestellt Zahl ist, sagen wir, 0.13 oder 32.39, dass definiert den Grad der Erregung des Neurons. Und es gibt eine andere wichtige Zahl, die auf jeder der verbindungen zwischen zwei Neuronen, der angibt, wie viel Erregung übertragen werden soll, von einem zum anderen. Diese Zahl modelliert Stärke der Synapsen zwischen den Neuronen des Gehirns. Je höher die Zahl, desto stärker die Verbindung, also mehr Erregung fließt von einem zum anderen.

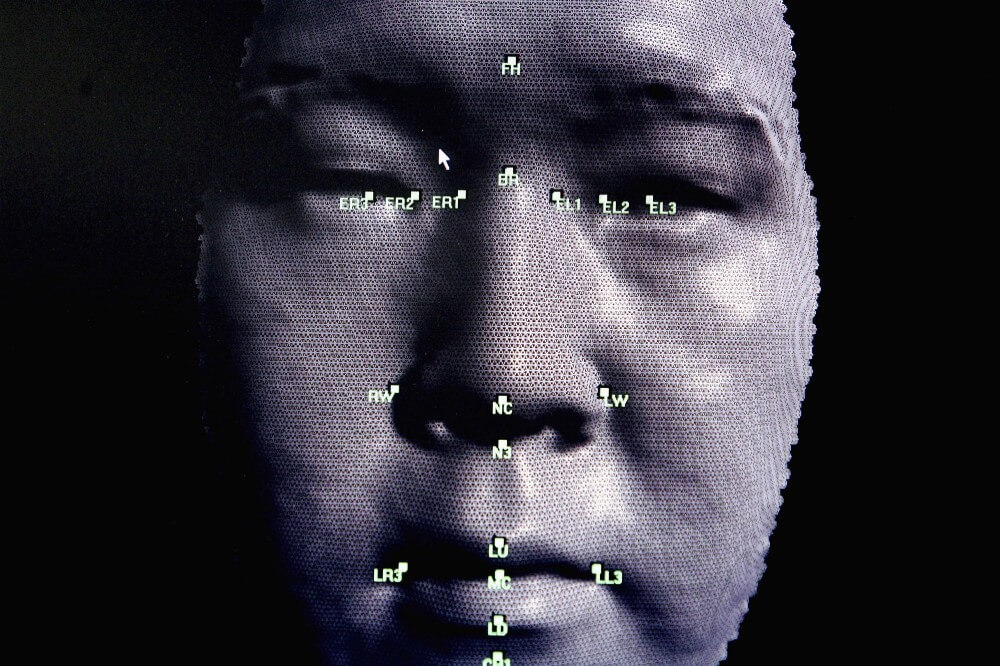

Eine der erfolgreichsten Anwendungen von tiefen neuronalen Netzen wurde die Erkennung von Bildern. Heute gibt es Programme, die erkennen, ob auf dem Bild hotdog. Einige vor zehn Jahren waren Sie unmöglich. Damit Sie funktionieren, müssen Sie zuerst ein Bild zu machen. Einfachheit halber sagen wir, dass diese schwarz-weiß-Bild 100 x 100 Pixel. Sie geben ihn neuronales Netz, indem Sie die Erregung der einzelnen simulierten Neurons im Einleitungstext Schicht, so dass es gleich der Helligkeit der einzelnen Pixel. Diese untere Schicht Sandwich: 10 000 Neuronen (100 x 100), die die Helligkeit der einzelnen Pixel im Bild.

Dann wird diese große Schicht von Neuronen verbinden Sie zu einem anderen großen Schicht von Neuronen, der schon über, sagen wir, in ein paar tausend, und Sie, wiederum, auf eine andere Ebene übertragen von mehreren tausend Neuronen, aber schon weniger und so weiter. Schließlich die oberste Schicht der Sandwich — Schicht Ausgabe — besteht aus zwei Neuronen — einer, der «Hot Dog» und die andere «nicht-Hot-Dog». Die Idee ist, ein neuronales Netzwerk zu trainieren erregt nur die erste dieser Neuronen, wenn auf dem Bild gibt es ein Hot Dog, und die zweite, wenn nicht. Бэкпроп, die Methode der inversen Verteilung Fehler, auf dem Hinton baute seine Karriere, macht genau das.

Бэкпроп sehr einfach, aber funktioniert am besten mit einer riesigen Menge von Daten. Das ist, warum Big data so wichtig sind für die KI — warum Sie mit solchem Eifer beschäftigen sich mit Facebook und Google und warum Vector Institute beschlossen, den Kontakt mit den vier größten Krankenhäusern in Kanada und kommunizieren.

In diesem Fall werden die Daten in Form von Millionen von Bildern, einige mit Hot Dogs, einige ohne; Trick, um diese Bilder beschriften wie die Hot Dogs. Wenn Sie ein neuronales Netzwerk zum ersten mal, die verbindungen zwischen den Neuronen haben eine zufällige Gewichts – Zufallszahlen, die sagen, wie viel Erregung wird über jede Verbindung. Ob die Synapsen des Gehirns ist noch nicht konfiguriert. Ziel бэкпропа — diese GEWICHTE ändern, so dass das Netzwerk funktioniert: also, wenn Sie übertragen das Bild hotdog auf die Unterste Schicht, Neuron «Hot Dog» in der obersten Schicht angeregt wird.

Angenommen, Sie nehmen den ersten Tutorial ein Bild von einem Klavier. Konvertieren Sie die Intensität der Pixel im Bild 100 x 100 in 10 000 zahlen, einer für jedes Neuron der unteren Schicht des Netzwerks. In dem Maße, wie die Erregung breitet sich über das Netzwerk in übereinstimmung mit der Stärke der Verbindung von Neuronen in benachbarten Schichten, alles kommt nach und nach bis zu der letzten Schicht, einer aus zwei Neuronen, die bestimmen, gibt es auf dem Bild Hot Dog. Da ist ein Bild mit dem Klavier, das Neuron «hotdog» sollte null zeigen, und das Neuron nicht «Hot Dog» soll die Zahl weiter nach oben. Angenommen, alles funktioniert nicht so. Nehmen wir an, das Netzwerk Bild hattest. Бэкпроп — ein Verfahren zur Stärkung der Energie der einzelnen verbindungen im Netzwerk, die es ermöglicht, Fehler zu beheben in diesem Beispiel lernen.

Wie funktioniert das? Sie beginnen mit den letzten zwei Neuronen und выясняете, wie falsch Sie sind: was ist der Unterschied zwischen Ihren zahlen Erregung und wie es sein sollte eigentlich. Dann werden Sie sehen jede Verbindung, die zu diesen Neuronen — nach unten durch die Schichten definieren und Ihren Beitrag zum Fehler. Halten Sie tun dies, bis Sie den ersten Satz von verbindungen an der Unterseite des Netzes. Zu diesem Zeitpunkt wissen Sie, was ist der Beitrag der einzelnen verbindungen in einen gemeinsamen Fehler. Schließlich ändern Sie alle das Gewicht, um in der Regel geringere Chancen auf Fehler. Diese so genannte «Methode des umgekehrten Ausbreitung Fehler» besteht darin, dass Sie gleichsam прогоняете Fehler zurück über das Netzwerk, beginnend mit der umgekehrten Ende, Ausgang.

Unglaubliche geschehen beginnt, wenn Sie dies tun mit Millionen oder Milliarden von Bildern: das Netzwerk beginnt gut zu bestimmen, ist in der Abbildung dargestellt hotdog oder nicht. Und was noch interessanter ist, ist die Tatsache, dass die einzelnen Schichten dieser Netze Bilderkennung beginnen zu «sehen» Bild so wie es ist macht unsere eigene visuelle System. Das heißt, die erste Schicht erkennt die Konturen — Neuronen angeregt werden, wenn die Konturen haben, und nicht aus der Fassung bringen, wenn Sie es nicht tun; die nächste Schicht definiert die Ausrüstungen der Konturen, Z. B. Ecken; die nächste Schicht beginnt, die Formen zu unterscheiden; die nächste Schicht findet allerlei Elemente wie «Brötchen offenen» oder «geschlossenen Brötchen», weil die entsprechenden Nervenzellen werden aktiviert. Das Netzwerk gliedert sich in hierarchische Ebenen, auch nicht als so programmiert.

Echte Intelligenz nicht beunruhigt, wenn das Problem ist etwas anders.

Das hat alle erstaunt. Es ist nicht so sehr in der Tatsache, dass neuronale Netzwerke gut zu klassifizieren Bild mit Hotdogs: Sie bauen eine Darstellung von Ideen. Mit dem Text wird es noch deutlicher. Sie können verfüttert man den Text von Wikipedia, viele Milliarden von Wörtern, einfaches neuronales Netz, indem er lehrte Sie verleihen jedes Wort zahlen, den entsprechenden возбуждениям jedes Neuron in der Schicht. Wenn man alle diese zahlen Koordinaten im komplexen Raum, finden Sie einen Punkt, bekannt ist in diesem Kontext als Vektor, für jedes Wort in diesem Raum. Dann unterrichten Sie das Netz so, dass die Worte, die in der Nähe auf den Seiten der Wikipedia, werden mit ähnlichen Koordinaten — und schwupps, passiert etwas seltsames: die Wörter, die ähnliche Werte, erscheinen in diesem Raum in der Nähe. «Insane» und «ausgehängt» werden; «drei» und «sieben» auch. Darüber hinaus Vektor-Arithmetik ermöglicht Ihnen, Vektor subtrahieren «Frankreich» aus «Paris», fügen Sie es zu «Italien» und «Rom» in der Nähe. Niemand hat gesagt нейросети, was Rom für Italien ist das gleiche, was Paris für Frankreich.

«Es ist erstaunlich», sagt Hinton. «Es ist schockierend». Neuronale Netze betrachtet werden als ein Versuch, die Dinge — Bilder, also Aufnahmen von Telefongesprächen, die medizinische Daten — und legen Sie Sie in, wie die Mathematiker sagen, mehrdimensionalen Vektorraum, in dem die Nähe oder Ferne Dinge wiedergeben, die wichtigsten Aspekte der realen Welt. Hinton ist der Auffassung, dass genau das macht das Gehirn. «Wenn Sie wissen wollen, was ist der Gedanke, — sagt er, — ich kann es Ihnen eine Reihe von Wörtern. Ich kann sagen: «John dachte: «Oops». Aber wenn Sie Fragen: was ist ein Gedanke? Was bedeutet für John haben diesen Gedanken? Denn in seinem Kopf nicht öffnenden Anführungszeichen, «Oops», schließenden Anführungszeichen, und überhaupt nicht so in der Nähe gibt. In seinem Kopf fließt eine gewisse neuronale Aktivität». Großes Muster neuronaler Aktivität, wenn Sie Mathematiker, abgefangen werden im Vektor-Raum, in dem die Aktivität eines jeden Neurons wird unbedingt der Zahl, und jede Zahl — Koordinate sehr großen Vektor. Laut Hinton, der Gedanke ist ein Tanz-Vektoren.

Es ist jetzt klar, warum das Institut der Vektor so genannt?

Hinton schafft ein Feld Verzerrung Realität, Sie wird ein Gefühl von Vertrauen und Begeisterung, inspirieren, zu glauben, dass für Vektoren gibt es nichts Unmögliches. Am Ende, Sie haben bereits selbst Autos, Zeigend Krebs-Computern, Instant-übersetzer für gesprochene Sprachen.

Und nur wenn Sie verlassen den Raum, Sie erinnern sich, dass diese Systeme «Deep learning» immer noch ziemlich dumm, obwohl seine demonstrative Kraft der Gedanken. Ein Computer, der sieht eine Reihe von Donuts auf den Tisch und automatisch signiert Sie als «einen Haufen Donuts liegen auf dem Tisch», scheint verständnisvollen Welt; aber wenn das gleiche Programm sieht ein Mädchen, das putzt sich die Zähne, und sagt, dass es «der junge mit dem Baseballschläger», merkt man, wie schwer dieses Verständnis, wenn es im Allgemeinen heißt.

Neuronale Netze — es ist nur eine gedankenlose und vage images Merkmale aktiviert ist, und wie nützlich können solche Merkmale aktiviert ist Abbildern — denn Sie bemühen sich zu integrieren in jede Software — Sie sind im besten Fall repräsentieren eine eingeschränkte Rasse Intelligenz, die leicht zu täuschen. Tiefes neuronales Netz, das Bild erkennt, kann völlig verwirrt, wenn Sie ein Pixel oder fügen visuelle Rauschen, unmerklich für den Menschen. Fast so oft, wie wir finden neue Wege des Deep-learning-Anwendungen, so oft wir mit seiner Beschränktheit. Selbst Autos können nicht fahren unter Bedingungen, die nicht gesehen haben. Maschinen können nicht zerlegen-Angebote, die erfordern gesunden Menschenverstand und das Verständnis, wie die Welt funktioniert.

Tiefe Ausbildung in gewisser Weise simuliert, was geschieht im menschlichen Gehirn, aber oberflächlich — was vielleicht erklärt, warum seine Intelligenz ist so ein manchmal oberflächlich. Бэкпроп nicht erkannt wurde während des Tauchgangs im Gehirn, versuche zu entziffern, die Idee; er wuchs aus den Modellen der Tiere lernen durch Versuch und Irrtum in altmodischen Experimenten. Und die meisten der wichtigsten Schritte, die gemacht wurden, seit seiner Einführung, nicht enthalten nichts neues zum Thema Neurobiologie; es wurden technische Verbesserungen, verdienten im Laufe der Jahre der Arbeit von Mathematikern und Ingenieuren. Was wissen wir über Intelligenz, nichts im Vergleich zu dem, was wir über ihn noch nicht wissen.

David Дювенод, Assistenzprofessor aus der gleichen Abteilung, was und Hinton, an der Universität Toronto, sagt, dass Tiefe Studiengebühren ähnlich Engineering bis zur Einführung der Physik. «Jemand schreibt eine Arbeit und sagt: «Ich habe diese Brücke, und es lohnt sich!». Ein anderer schreibt: «Ich habe diese Brücke, und er stürzte, aber ich fügte hinzu, Stütze und er steht». Und alle verrückt auf stützen. Jemand fügt einen Bogen — und alle so: der Bogen ist cool! Mit der Physik können Sie wirklich verstehen, was funktioniert und warum. Wir haben erst vor kurzem begonnen zu wechseln, zumindest zu einem gewissen Verständnis der künstlichen Intelligenz».

Und Hinton selbst sagt: «Auf den meisten Konferenzen sprechen über die Einführung von kleinen änderungen statt, um genau zu überlegen und sich Fragen: «Warum ist das, was wir jetzt tun, nicht funktioniert? Was ist der Grund? Konzentrieren wir uns auf dieser».

Der Blick von außen schwer zu machen, wenn alles, was Sie sehen, ist die Förderung für die Förderung. Aber die neuesten Fortschritte im Bereich der KI in geringerem Umfang war und in einem größeren wissenschaftlichen — ingenieurmssigen. Obwohl wir besser verstehen, welche Veränderungen verbessern das Deep-learning-System, wir sind noch vage vorstellen, wie diese Systeme arbeiten und ob Sie jemals zusammen in etwas genauso mächtiges wie der menschliche Verstand.

Es ist wichtig zu verstehen, konnten wir abrufen, was Sie können, aus бэкпропа. Wenn ja, dann erwartet uns ein Plateau in der Entwicklung der künstlichen Intelligenz.

Geduld

Wenn Sie sehen möchten der nächste Durchbruch, so etwas wie die Grundlagen für Maschinen mit sehr viel flexibler Intelligenz, sollten Sie auf die Idee, sich an Forschung, wie eine Studie бэкпропа in den 80er Jahren: wenn intelligente Menschen aufgeben, weil Ihre Ideen noch nicht gearbeitet.

Vor ein paar Monaten war ich im Center for Minds, Brains and Machines, Mehrzweckraum Institution, die in MIT, um zu sehen, wie mein Freund Эял Дехтер verteidigt seine Dissertation zum cognitive Science. Vor Beginn der Aufführungen seiner Frau Amy, seinen Hund Ruby und seiner Tochter Susanne unterstützt ihn und wünschten viel Glück.

Эял begann seinen Vortrag mit der spannenden Frage: wie kommt es, dass Suzanne, die nur zwei Jahre gelernt, zu sprechen, zu spielen, Geschichten Folgen? Was im menschlichen Gehirn, was ihm erlaubt, so gut zu lernen? Lernen, ob ein Computer jemals lernen so schnell und reibungslos?

Wir verstehen das neue Phänomen in Bezug auf Dinge, die wir bereits verstehen. Wir brechen in Stücke Domain und lernen ihn Stück für Stück. Эял — Mathematiker und Programmierer, er denkt über die Aufgaben — zum Beispiel, machen Soufflé — wie über komplexe Computerprogramme. Aber weil Sie nicht lernen tun Soufflé, заучивая Hunderte von kleinsten Anweisungen des Programms wie «drehen Sie die Ellbogen auf 30 Grad, dann schauen Sie sich auf der Arbeitsplatte, dann ziehen Sie Ihren Finger, dann…». Würde man dies tun, in jedem neuen Fall, die Ausbildung wäre unerträglich, und Sie würden in der Entwicklung stehengeblieben. Stattdessen sehen wir in dem Programm die Schritte der obersten Ebene wie «Schneebesen Proteine», die an sich bestehen aus субпрограмм wie «Smash the Egg» und «trennen Sie die weißen aus dem Eigelb».

Computer tun es nicht und daher scheinen dumm zu sein. Um Deep-learning-System erkennt hotdog, müssen Sie füttern Sie 40 Millionen Bilder Hot Dogs. Чтоюы Susanne erfuhr hotdog, nur zeigen Sie Ihr Hot Dog. Und schon lange vorher bei Ihr wird das Verständnis der Sprache, das geht stark tiefer erkennen des Auftretens der einzelnen Wörter zusammen. Im Gegensatz zu Computer, in Ihrem Kopf eine Vorstellung davon, wie die Welt funktioniert. «Ich bin überrascht, dass die Leute Angst haben, dass die Computer nehmen Ihnen die Arbeit», sagt Эял. «Computer ersetzen können Anwälte nicht, weil die Juristen machen, etwas kompliziert. Und weil die Juristen hören und sprechen mit Menschen. In diesem Sinne sind wir sehr weit von allem».

Echte Intelligenz nicht zu, wenn Sie leicht ändern Sie die Anforderungen an eine Lösung. Und der entscheidende these Эяла war eine Demonstration der genau das, im Prinzip, wie man den Computer, so zu arbeiten: lebendig anwenden, was er schon kennt, auf neue Herausforderungen schnell zu erfassen on-the-Fly, ein Experte zu werden in einem völlig neuen Bereich.

Im Grunde ist es das Verfahren, den Algorithmus nennt er «Studien-Komprimierung». Es gibt Computer die Funktion des Programmierers, um eine Bibliothek von wiederverwendbaren modularen Komponenten, um komplexere Programme. Nichts zu wissen über die neue Domäne, der Computer versucht, zu strukturieren Kenntnisse über ihn, nur studieren, eine Konsolidierung nachweisbare und weiter durch das erlernen, wie ein Kind.

Sein Ratgeber, Sie Joshua Tenenbaum, einer der meistzitierten Forscher der KI. Name Тененбаума tauchte in der Hälfte der Gespräche, die ich hatte mit anderen Wissenschaftlern. Einige der wichtigsten Leute in der DeepMind — Team AlphaGo, Episch обыгравшего Weltmeisters in das go-Spiel im Jahr 2016 — arbeiteten unter seiner Aufsicht. Er beteiligt in Startup-Unternehmen, das versucht zu geben, selbstverwaltet Autos intuitives Verständnis der Grundlagen der Physik und Absichten anderer Fahrer, um jene besser предвосхищали was geschieht in Situationen, mit denen Sie zuvor nicht konfrontiert waren.

These Эяла noch nicht in der Praxis angewandt, auch im Programm wurde nicht eingeführt. «Probleme, an denen Эял, sehr, sehr kompliziert», sagt Tenenbaum. «Es ist notwendig um viele Generationen später».

Wenn wir setzten uns bei einer Tasse Kaffee, sagte Tenenbaum, was erforscht die Geschichte бэкпропа für Inspiration. Seit Jahrzehnten бэкпроп war eine Manifestation der steilen Mathematik, zum größten Teil auf irgendetwas nicht fähig. In dem Maße, wie die Computer wurden schneller, und die Technik komplizierter, das alles verändert. Er hofft, dass etwas ähnliches geschieht mit seiner eigenen Arbeit und den arbeiten seiner Schüler, aber «es kann noch ein paar Jahrzehnte».

Ueber Hinton, er ist überzeugt, dass die überwindung der Einschränkungen der KI verbunden mit der Schaffung einer «Brücke zwischen информатикой und Biologie». Бэкпроп, aus dieser Sicht, war ein Triumph biologisch inspirierten Computing; die Idee ursprünglich stammte nicht aus dem Engineering und der Psychologie. Deshalb jetzt Hinton versucht, diesen Trick wiederholen.

Heute neuronale Netze bestehen aus einer großen, flachen Schichten, sondern in der Großhirnrinde des Menschen diese Neuronen line-up nicht nur horizontal, sondern auch vertikal in Spalten. Hinton hat eine Ahnung, wofür diese Spalten — in der Vision, zum Beispiel, Sie ermöglichen die Erkennung von Objekten auch bei der Veränderung der Perspektive. So schafft er eine künstliche Version und nennt Sie «Kapseln» — für die überprüfung dieser Theorie. Bis dass nichts herauskommt: die Kapseln sind nicht besonders verbessert die Leistungsfähigkeit Ihrer Netze. Aber vor 30 Jahren mit бэкпропом war das gleiche.

«Es muss funktionieren», sagt er über die Theorie der Kapseln, lachen über die eigene Angeberei. «Und die Tatsache, dass es noch nicht funktioniert, ist es nur eine vorübergehende Irritation».

Nach den Materialien Medium.com

Künstliche Intelligenz und Geoffrey Hinton: der Vater «Deep learning»

Ilja Hel