Informasjonen Teknologi Og Innovasjon Foundation har sluppet sin nominerte for sin årlige Luddite Awards. Å anerkjenne “den verste av årets verste innovasjon killers,” årets avling omfatter alt fra restriksjoner på bil-deling av forbud automatisk lisens plate lesere. Men ved å henvise til “AI alarmists” som neo-Luddites, ITIF har gått for langt.

Den ITIF er en ikke-for-profit tenketanken basert i Washington, D.C. som fokuserer på en offentlig politikk som oppmuntrer til teknologisk innovasjon. Hvert år, den ITIF setter sammen en liste over hva de mener er årets verste innovasjon killers. Oppkalt Ned Lud, en Engelskmann som ledet en bevegelse i begynnelsen av det 19. århundre for å ødelegge mekanisert veven, prisen anerkjenner de mest groteske eksempler på en organisasjon, regjeringen eller enkelte å bekjempe utviklingen av teknologisk innovasjon.

“Neo-Luddites ikke lenger bruke slegge, men de bruke noe mye kraftigere: dårlige ideer,” skriver Robert D. Atkinson, ITIF er grunnlegger og president. “For de arbeider for å overbevise politikere og publikum at innovasjon er årsaken, er ikke løsningen på noen av våre største sosiale og økonomiske utfordringer, og derfor noe til å bli forpurret.” Han sier “de søker en verden som i stor grad er fri for risiko, innovasjon, eller ukontrollert endring.”

I ingen spesiell rekkefølge, her er årets nominerte:

- Alarmists tout en kunstig intelligens apokalypsen

- Talsmenn søke et forbud mot “killer roboter”

- Stater grense automatisk lisens plate leserne

- Europa, Kina, og andre velger taxi sjåfører over bil-deling passasjerer

- Papirindustrien motsetter e-merking

- Californias guvernør veto RFID i førerkort

- Wyoming fredløse borger vitenskap

- Federal Communications Commission grenser bredbånd innovasjon

- Senter for mattrygghet kamper genetisk forbedret mat

- Ohio og andre forbud rødt lys-kameraer

Den ITIF utstedt en vedlagt rapport som forklarer årets avling av nominerte, så hvis du vil ha en detaljert forklaring for hvert element ovenfor, foreslår jeg at du sjekker det ut. Instituttet har også lansert en avstemning for å spørre publikum til å stemme på sin favoritt oppføring. “Vinneren” vil bli annonsert en gang i januar.

Sponset

Se på listen over nominerte, de siste syv elementer fornuftig, selv om jeg kan forstår hvorfor RFID-brikker i førerkort kan bli sett på som en personvern og sikkerhet bekymring. Men som for de to første, og oppføringen av “AI alarmists” som neo-Luddites, vel, nå fikk jeg litt forskrekket.

Å hindre en AI Apokalypsen

Den ITIF klage om alarmists touting en kunstig intelligens apokalypsen har å gjøre med et åpent brev som er utviklet av Future of Life Institute tidligere i år. Bill Gates, Stephen Hawking, Elon Musk, og andre offentlige personer har underskrevet brevet, som advarte om potensialet for AI-for til slutt å rømme fra vår kontroll og dukke opp som en apokalyptisk trussel. På samme tid, men underskriverne presset på for ansvarlig AI tilsyn som en måte å redusere risiko og sikre “samfunnsmessig nytte” av teknologien.

(Bilde: Avengers: Age of Ultron (2015))

Men til ITIF, dette er bare et forsøk på å stall viktig innovasjon. Hva er mer, institutt hevder at AI er tydeligvis ikke noe å bekymre seg fordi det er for langt ut i fremtiden.

“Om slike systemer vil utvikle seg full autonomi er et diskutabelt spørsmål, men det bør ikke være diskutabel, er at dette vil være mulig i fremtiden er en lang, lang vei av (mer som et århundre enn et tiår), og det er derfor for tidlig å bekymre om ‘Skynet’ å bli selvbevisst, sier Atkinson, “Faktisk, fortsetter negativ kampanje mot kunstig intelligens potensielt kunne tørke opp midler til AI-forskning, annet enn penger for slik kontroll, snarere enn aktivere AI.”

Atkinson hevder disse sci-fi-dommedag scenarier er å gjøre det vanskeligere for publikum, politikere og forskere til å støtte mer finansiering for AI-forskning.

Godt, ITIF unnlatt å nevne den nylig annonserte ikke-for-profit OpenAI research company co-grunnlagt av Elon Musk. $1 milliard initiativet er forpliktet til å “fremme digital intelligens på en måte som er mest mulig egnet til å dra fordel menneskeheten som et hele.” Prosjektet blir med andre lignende initiativ lansert av fremtredende selskaper som Google, Apple og IBM. Flere lignende faglige initiativer finnes også, blant annet Future of Humanity Institute ved Oxford, og har nylig lansert Senter for Studier av Eksistensiell Risiko ved Universitetet i Cambridge.

Disse initiativene—for ikke å nevne at milliarder blir brukt på AI-forskning og utvikling rundt om i verden—viser at Atkinson er bekymringer er overdrevet. Hva er mer, og i ånden av FLI åpent brev, det er definitivt ikke for tidlig å tenke på den potensielle risikoen. Menneskehetens overlevelse kan være på spill. Bruk av sterk kunstig intelligens—og spesielt kunstig superintelligens—kan vise seg å være den mest forstyrrende teknologisk innovasjon i historien av våre arter, så det er kritisk at vi får det riktig. Klart, vi snakker ikke om Ned Lud ‘ s steam-drevet vever.

Død til å Drepe Maskiner

Og så er det spørsmålet om autonome våpen. En del av ITIF klage har å gjøre med en annen åpent brev bestilt av FLI, en kaller for et regelrett forbud mot autonome å drepe maskiner. Underskriverne inkludert Hawking, Moskus, Steve Wozniak, Noam Chomsky, MIT fysikeren Max Tegmark, og Daniel C. Dennett.

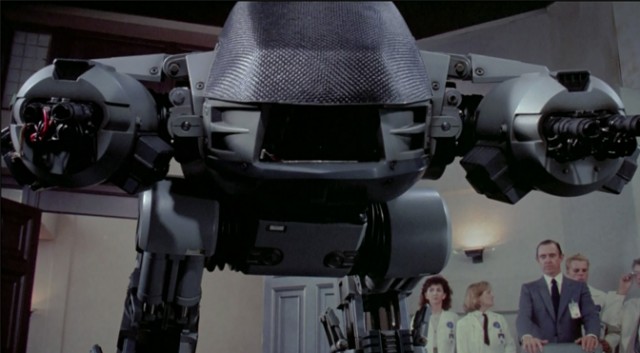

(Bilde: Robocop (1987))

Den ITIF hadde også et problem med en fn-møtet som ble holdt tidligere i år for å vurdere et formelt forbud eller andre restriksjoner på killer AI, og en spesiell rapport ført i pennen av Human Rights Watch og Harvard Law School som oppfordret for et moratorium på slike våpen.

Atkinson sier argumenter mot å drepe maskiner “overser det faktum at de militære klart vil være til nytte, fordi det erstatter roboter for soldater på slagmarken vil øke militære evner samtidig vesentlig å redusere risikoen til sitt personell,” og legger til at det er “mulig det autonome våpen kan være programmert til å engasjere bare kjent fiendtlige stridende soldater, som kan også føre til en reduksjon i sivile tap.”

Atkinson avslutter med å si at, “kampen for å forby autonome våpen, mye som slåss om kunstig intelligens, virker mot de samfunnsmessige mål om å bygge innovasjoner som vil forbedre menneskers liv.”

Den ITIF er riktig å påpeke at robot våpen har potensial til å redusere dødsfall på å drepe feltet, men forestillingen om at disse systemene vil være i stand til diskriminering mellom stridende og sivile er tøft å svelge. Hva mer er, som med alle militære innovasjon, og det må antas at fienden vil etter hvert utvikle sin egen versjon. Til slutt, en AI våpenkappløp kan føre til superintelligent systemer som kamp om dominans utenfor menneskelig fatteevne og kontroll. Skulle dette skje, vil vi ha noe annet valg enn å lene seg tilbake og håpe vi ikke blir ødelagt i prosessen.

Et grunnleggende problem med ITIF er sin urokkelige tro på menneskelige samfunn til å tilpasse sin teknologi. Til dags dato, har vi i stor grad lyktes i å gjøre det. Vi har til og med klart å overleve — i hvert fall for nå — utviklingen av den første apokalyptiske-skala våpen i form av atomvåpen. Dessverre, andre farer som venter oss i fremtiden, slik at vi best bli klar.

På samme tid, vi fortjener retten til å varsle om disse potensielle farene uten frykt for å bli stemplet en Luddite.

[ ITIF JEG, II, III ]

E-post forfatteren på george@gizmodo.com og følg ham på @dvorsky. Øverste bilde: Ex Machina (2015)