Afbeelding: University at Albany, SUNY

Afbeelding: University at Albany, SUNY

De snelheid waarmee deepfake video ‘ s zijn vooruitgang is indrukwekkend en diep verontrustend. Maar de onderzoekers hebben beschreven een nieuwe methode voor het detecteren van een “duidelijk teken” van deze gemanipuleerde video ‘ s, welke kaart een persoon het gezicht op het lichaam van een ander. Het is een fout, zelfs de gemiddelde mens zou opmerken: een gebrek aan knippert.

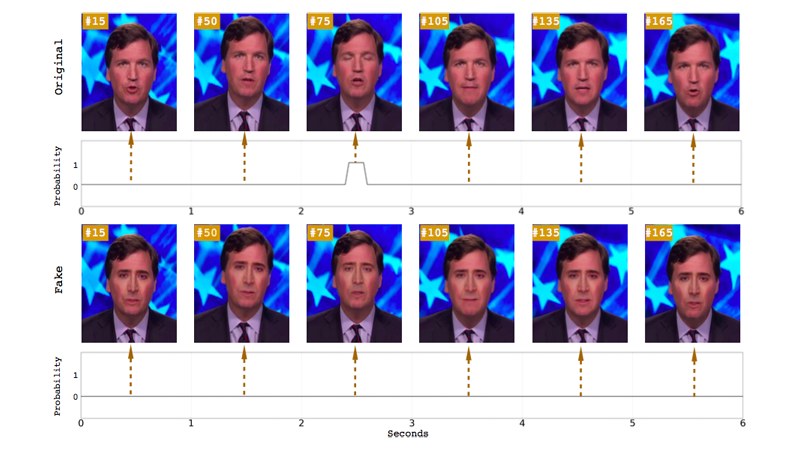

Onderzoekers van de University at Albany, SUNY ‘ s computer science department onlangs een paper gepubliceerd met de titel “In Ictu Oculi: het Blootstellen van AI Gegenereerd Nep-Face Video’ s door het Detecteren van de Ogen te Knipperen.” De paper beschrijft hoe ze op een combinatie van twee neurale netwerken effectiever bloot gesynthetiseerd gezicht video ‘ s, die vaak over het hoofd “spontane en onwillekeurige fysiologische activiteiten, zoals ademhaling, hartslag en eye movement.”

De onderzoekers er rekening mee dat de gemiddelde rusten knipperen tarief voor de mens is 17 knipperen per minuut, wat stijgt naar 26 knipperen per minuut wanneer iemand aan het woord is, en daalt tot 4,5 per minuut knippert wanneer iemand aan het lezen is. De onderzoekers voegen dat deze onderscheidingen zijn de moeite waard aandacht te besteden aan “omdat veel van de talking-head politici zijn waarschijnlijk te lezen als ze gefilmd worden.” Dus als een onderwerp in een video niet knipperen bij, het is een makkelijk te vertellen dat de beelden niet legit.

Er is een reden onderwerpen in deepfake video ‘s don’ t blink: de Meeste training datasets gevoed neurale netwerken niet zijn gesloten-eye foto ‘s, als de foto’ s van mensen die u online heeft geplaatst in het algemeen tonen hun ogen open. Dat is gevolgschade, gegeven iemand moet het verzamelen van veel foto ‘s van een individu om een deepfake van hen, en dit kan worden gedaan door middel van een open-bron-foto-schrapen-tool die pakt het publiek beschikbare foto’ s van de target online.

Vorige artikelen hebben gewezen op het gebrek aan oog-knippert als een manier om te ontdekken deepfakes, maar de University at Albany onderzoekers zeggen dat hun systeem is nauwkeuriger dan eerder voorgestelde methoden voor de opsporing. Eerdere studies gebruikt oog aspect ratio (OOR) of een convolutional neurale netwerk-gebaseerde (CNN) classifiers te herkennen als de ogen werden geopend of gesloten is. In dit geval, de onderzoekers combineerden de CNN-gebaseerde methode met een recursieve neuraal netwerk (RNN), een aanpak die rekening houdt met de vorige eye staten naast de individuele frames van een video.

In tegenstelling tot een zuiver CNN model, de onderzoekers zeggen dat hun Lange-termijn Terugkerende Convolutional Netwerk (LRCN) aanpak kan “effectief voorspellen ogen staat, zodanig dat het meer vlot en accuraat.” Volgens het papier, deze aanpak heeft een nauwkeurigheid van 0.99, in vergelijking met CNN ‘ s 0.98 en OOR 0.79.

Op zijn minst, de onderzoekers de bevindingen geven aan dat de machine learning ontwikkelingen die hebben geleid tot de oprichting van deze ultrarealistic nep-video ‘ s kan een hand in bloot te stellen. Maar deepfakes zijn nog steeds te verbeteren alarmerend snel. Bijvoorbeeld, een nieuw systeem genaamd Deep Video Portretten laat een bron acteur manipuleren van het portret video van iemand anders, en het zorgt voor een aantal fysiologische signalen, inclusief knipperen en oog staar.

Het is geruststellend om te zien experts op zoek naar manieren om ter plaatse real video ‘ s van valse degenen, vooral omdat slechte acteurs blijven misbruik maken van de technologie te misbruiken vrouwen en mogelijk vooraf het verspreiden van vals nieuws. Maar het blijft te bezien of deze detectie methoden zal dan in de snelle vooruitgang van deepfake tech. En, meer concerningly, als het publiek zal zelfs de tijd nemen om me af te vragen of de video, ze kijken echt of het product van een internet-troll.

“In mijn persoonlijke mening, het meest belangrijk is, is dat het algemene publiek bewust te worden van de mogelijkheden van de moderne technologie voor video-generatie en bewerken,” Michael Zollhöfer, visiting assistant professor aan de Universiteit van Stanford, die heeft geholpen bij het ontwikkelen van Diepe Video Portretten, schreef in een blog post. “Dit zal hen in staat stellen om meer na te denken kritisch na over de video-inhoud die ze dagelijks consumeren, vooral als er is geen bewijs van oorsprong.”

[h/t Het Registreren]