En massiv ny videodataset hjälper till att utbilda smarta assistenter och robotar-men det finns uppenbara farhågor om hur tekniken kommer att användas.

av

14 oktober 2021

Vi tar det för givet att maskiner kan känna igen vad de ser på foton och videor. Den förmågan vilar på stora datamängder som ImageNet, en handkurerad samling av miljontals foton som används för att träna de flesta av de bästa bildigenkänningsmodellerna under det senaste decenniet.

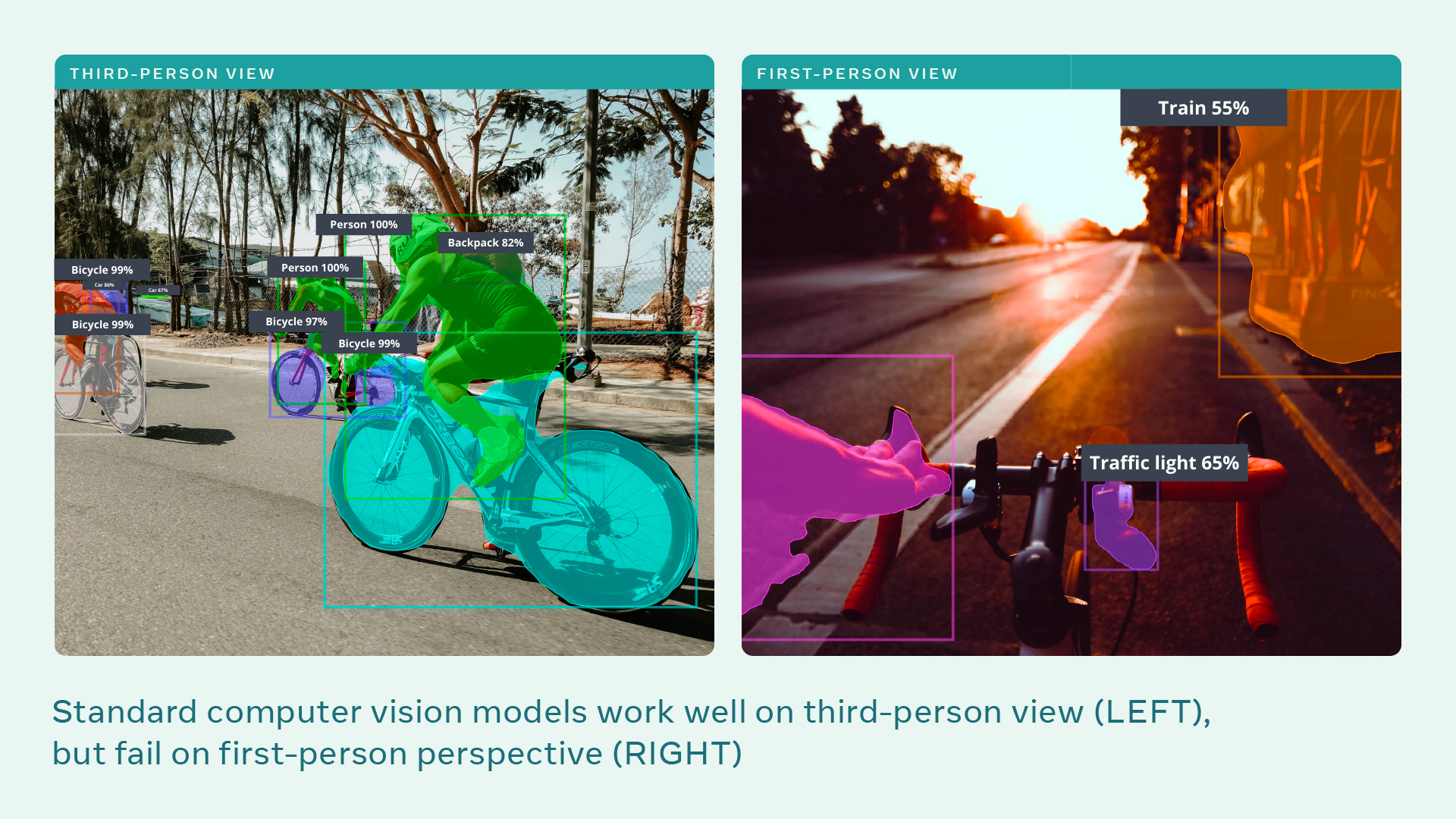

Men bilderna i dessa datauppsättningar skildrar en värld av kuraterade objekt – ett bildgalleri som inte fångar upp vardagslivet som människor upplever det. Att få maskiner att se saker som vi gör kommer att ta ett helt nytt tillvägagångssätt. Och Facebooks AI -lab vill ta ledningen.

Det är att starta ett projekt, kallat Ego4D, för att bygga AI: er som kan förstå scener och aktiviteter betraktade från ett förstapersonsperspektiv-hur saker ser ut för de inblandade, snarare än för en åskådare. Tänk på rörelse-suddiga GoPro-bilder tagna i tjockleken av åtgärden, i stället för väl inramade scener som tagits av någon på sidlinjen. Facebook vill att Ego4D ska göra för förstapersonsvideo vad ImageNet gjorde för foton.

Relaterad berättelse

Varför Facebook använder Ray-Ban för att göra anspråk på våra ansikten

Varför Facebook använder Ray-Ban för att göra anspråk på våra ansikten

För att bygga metaversen behöver Facebook att vi vänjer oss vid smarta glasögon.

Under de senaste två åren har Facebook AI Research (FAIR) samarbetat med 13 universitet runt om i världen för att sätta ihop den största datauppsättningen av förstapersonsvideo-särskilt för att utbilda modeller med djup inlärning av bildigenkänning. AI -utbildade på datamängden kommer att bli bättre på att styra robotar som interagerar med människor eller tolka bilder från smarta glasögon. “Maskiner kommer att kunna hjälpa oss i vårt dagliga liv bara om de verkligen förstår världen genom våra ögon”, säger Kristen Grauman på FAIR, som leder projektet.

Sådan teknik kan stödja människor som behöver hjälp i hemmet eller vägleda människor i uppgifter som de lär sig att utföra. “Videon i den här datamängden är mycket närmare hur människor observerar världen”, säger Michael Ryoo, datorvisionsforskare vid Google Brain och Stony Brook University i New York, som inte är engagerad i Ego4D.

Men de potentiella missbruken är tydliga och oroande. Forskningen finansieras av Facebook, en jätte på sociala medier som nyligen anklagats i den amerikanska senaten för att sätta vinster över människors välbefinnande-vilket bekräftas av MIT Technology Review: s egna undersökningar.

Facebooks affärsmodell , och andra Big Tech -företag, är att vrida så mycket data som möjligt från människors onlinebeteende och sälja dem till annonsörer. AI som beskrivs i projektet kan sträcka sig till människors vardagliga offline -beteende, avslöja vilka föremål som finns i ditt hem, vilka aktiviteter du tyckte om, vem du tillbringade tid med och till och med där din blick dröjde kvar – en oöverträffad grad av personlig information. < /p>

“Det finns arbete med integritet som måste göras när du tar detta ur världen av undersökande forskning och till något som är en produkt”, säger Grauman. ”Det arbetet kan till och med inspireras av det här projektet.”

FACEBOOK

FACEBOOK Den största tidigare datauppsättningen av förstapersonsvideo består av 100 timmars bilder av människor i köket. Ego4D -datauppsättningen består av 3025 timmars video inspelad av 855 personer på 73 olika platser i nio länder (USA, Storbritannien, Indien, Japan, Italien, Singapore, Saudiarabien, Colombia och Rwanda).

Deltagarna hade olika åldrar och bakgrunder; några rekryterades för sina visuellt intressanta yrken, som bagare, mekaniker, snickare och landskapsarkitekter.

Tidigare datamängder bestod vanligtvis av halvskriptade videoklipp som bara var några sekunder långa. För Ego4D hade deltagarna huvudmonterade kameror i upp till 10 timmar åt gången och fångade första personers video av dagliga aktiviteter utan skriven, inklusive att gå längs en gata, läsa, tvätta, handla, leka med husdjur, spela brädspel och interagera med andra människor. Några av filmerna innehåller också ljud, data om var deltagarnas blick var fokuserad och flera perspektiv på samma scen. Det är den första datauppsättningen i sitt slag, säger Ryoo.