Ny forskning visar att hjärnans minneskapacitet är tio gånger större än tidigare uppskattningar. Det betyder att det är i petabyte—vilket placerar det nära till World Wide Web territorium.

Den mänskliga hjärnan är ofta jämfört med en dator. En aspekt i synnerhet som lämpar sig väl för dessa typer av jämförelser är minnet. När forskare talar om minne, de hänvisar till RAM-minne (random access memory) och hårddisk för lagring. När man hänvisar till den mänskliga hjärnan har forskare talar av korttidsminne, ARBETSMINNE och långtidsminne, som är besläktad till en hårddisk. Följaktligen, forskare tycka att det är bra att analogize vår hjärna lagringskapacitet till en dator, vilket förklarar varför de mäta det i bitar och bytes.

Tyvärr, det finns en bristande samsyn på hur mycket information som våra hjärnor är kapabla att lagra. Uppskattningarna varierar från en terabyte till 100 terabyte till 2 500 terabyte (en terabyte 1000 gb). Men enligt en ny studie från Salk Institute visar dessa uppskattningar verkar vara en storleksordning för låg. Genom att skapa en databaserad rekonstruktion av en del av en råtta i hjärnan, ett team som leds av Salk Institute Terry Sejnowski har visat att den mänskliga hjärnans minneskapacitet är faktiskt i petabyte utbud. Detaljerna i deras arbete kan nu hittas den vetenskapliga tidskriften eLife.

“Detta är en riktig bomb i området neurovetenskap,” sade Sejnowski i ett pressmeddelande. “Vi upptäckt nyckeln till att låsa upp den design principen för hur hippocampus nervceller funktion med låg energi men hög beräkning makt. Våra nya mätningar av hjärnans minneskapacitet öka konservativa uppskattningar med en faktor 10 till minst en petabyte, i samma division som World Wide Web.”

För att vara rättvis, det är i samma område som Webben, men det är inte riktigt i samma division som Webben. Salk forskare verkar vara en överdrift lite. Om vi ser till de Fyra Stora—Google, Amazon, Microsoft och Facebook—deras servrar enbart lagra minst 1200 i petabyte mellan dem. Som exkluderar resten av Webben, inklusive lagring leverantörer som Dropbox, Barracuda, och SugarSync.

Sponsrade

Men en petabyte är fortfarande en stor mängd data. Uttryckt numeriskt, det är 250 bytes. En bra liknelse är den totala mängden data som samlats på US Library of Congress, som är ungefär 235 terabyte. En petabyte är ungefär fyra gånger så mycket. Sätta ännu ett annat sätt, en petabyte är tillräckligt för att lagra DNA-sekvensen för hela befolkningen i Usa två gånger om. Så våra hjärnor inte har motsvarande lagringskapacitet på hela Webben, men det är fortfarande en stor data-reservoaren.

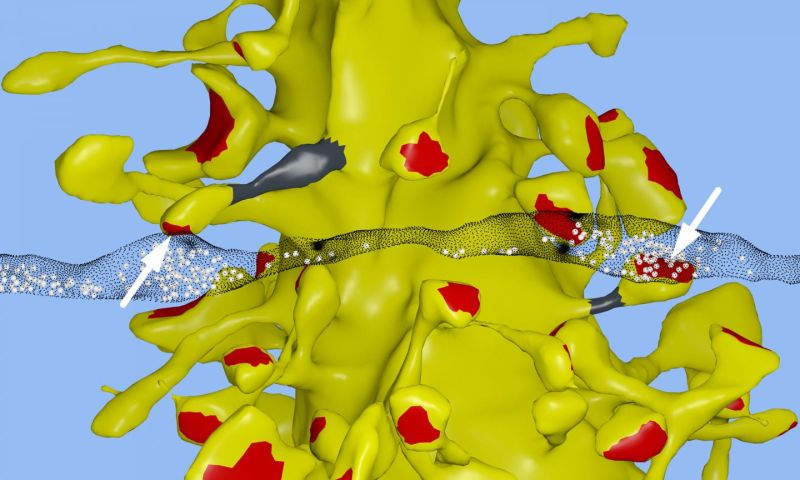

Laget skapade en datoriserad 3D-rekonstruktion av råtta hippocampus vävnad (minnet centrum av hjärnan), som visade något helt oväntat. Vissa nervceller verkade vara att skicka dubbla meddelanden att ta emot nervceller. Spännande, de bestämde sig för att mäta och jämföra storleken på två liknande synapser, vilket de hoppades skulle förbättra deras förståelse av synaptic storlek. Detta står i kontrast till hur neuroforskare vanligtvis hänvisa till storlekar av nervceller i form av små, medelstora och stora. Det är problematiskt, med tanke på att den minneskapacitet av nervceller beror på storleken av synapser.

Forskarna upptäckte att synapser i alla storlekar varierar i steg så små som åtta procent. Så det kan vara så många som 26 kategorier av storlekar av synapser. Denna “synaptisk plasticitet” betyder att det är 10 gånger mer diskreta storlekar av synapser än man tidigare trott. I datoriserad form, som motsvarar cirka 4,7 bitar av information. Innan denna studie har forskare trott att hjärnans var kapabel till, bara en till två bitar för kort och lång minnet lagras i hippocampus.

“Detta är ungefär en storleksordning av precision mer än någon någonsin har kunnat föreställa sig,” sade Sejnowski.

Denna upptäckt bidrar också till att förklara hjärnans förvånande effektivitet, vilket i förlängningen skulle kunna leda till ultraprecise, super-efficient, datorer, inklusive dem som använder djupt lärande och artificiella nät. Så på samma sätt som datorer som hjälper oss att förstå den mänskliga hjärnan, dessa typer av neurala insikter som hjälper oss att bygga mer effektiva och kraftfulla datorer.

[eLife]

Översta bilden: Salk Institute

E-post författaren på george@gizmodo.com och följ honom på @dvorsky.